La carenza di chip Nvidia mette in difficoltà le startup di intelligenza artificiale alla ricerca di potenza di calcolo

Shortened version 'La carenza di chip Nvidia mette in difficoltà le startup di IA nella ricerca di potenza di calcolo.

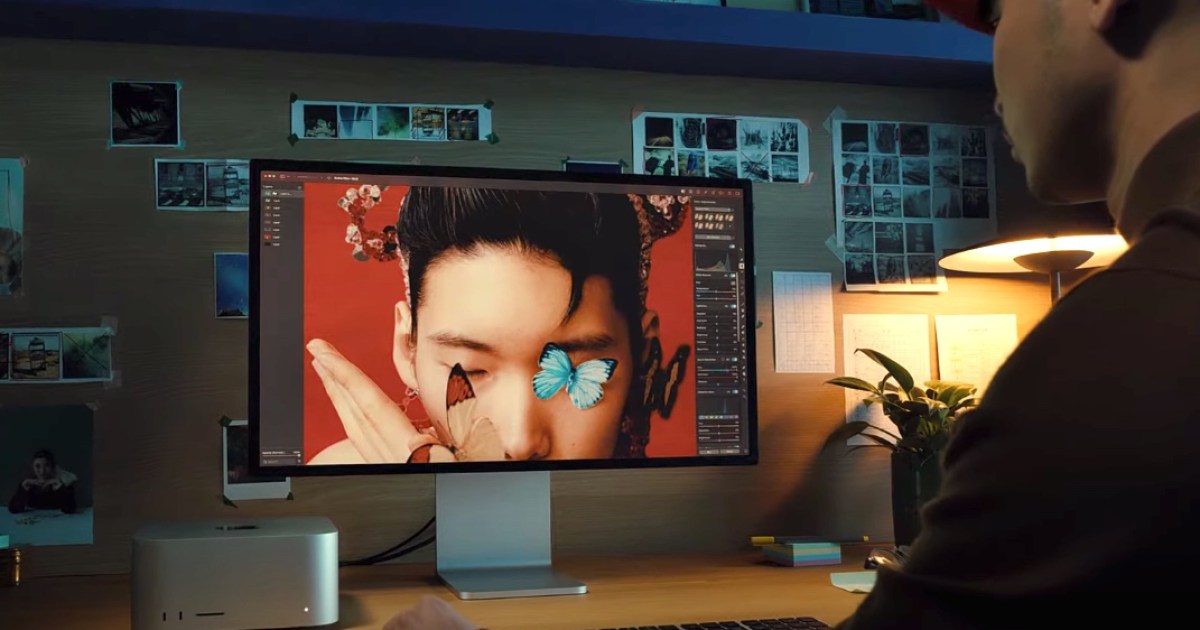

Verso le 11 del mattino, durante i giorni feriali, mentre l’Europa si prepara per chiudere i battenti, la costa est degli Stati Uniti entra nella fatica del mezzogiorno e la Silicon Valley si avvia, l’IA image generator della startup Astria con sede a Tel Aviv è sempre molto impegnata. Tuttavia, l’azienda non trae molto profitto da questo picco di attività.

Aziende come Astria, che sviluppano tecnologie di intelligenza artificiale, utilizzano le unità di elaborazione grafica (GPU) per addestrare il software che apprende i modelli nelle foto e in altri media. Le GPU gestiscono anche l’inferenza, ossia l’applicazione di tali apprendimenti per generare contenuti in risposta alle richieste degli utenti. Ma la corsa globale all’integrazione dell’IA in ogni app e programma, combinata con le sfide di produzione che risalgono all’inizio della pandemia, ha creato una scarsità di GPU.

Questa carenza di approvvigionamento significa che durante i momenti di picco, le GPU ideali presso il principale fornitore di cloud computing di Astria (Amazon Web Services), necessarie per generare immagini per i suoi clienti, sono al massimo della capacità e l’azienda è costretta a utilizzare GPU più potenti e costose per portare a termine il lavoro. I costi aumentano rapidamente. “È solo una questione di quanto si è disposti a pagare”, dice Alon Burg, fondatore di Astria, scherzando sul fatto che si chiede se investire in azioni di Nvidia, il più grande produttore di GPU al mondo, sarebbe più redditizio rispetto alla sua startup. Astria addebita ai suoi clienti in modo da bilanciare questi picchi costosi, ma sta comunque spendendo più del desiderato. “Mi piacerebbe ridurre i costi e assumere alcuni ingegneri in più”, afferma Burg.

Non c’è una fine imminente alla carenza di GPU. Il leader di mercato, Nvidia, che rappresenta circa il 60-70% dell’offerta globale di chip server per l’IA, ha annunciato ieri di aver venduto un record di GPU per data center del valore di 10,3 miliardi di dollari nel secondo trimestre, in aumento del 171% rispetto all’anno precedente, e che le vendite dovrebbero superare le aspettative anche nel trimestre corrente. “La nostra domanda è enorme”, ha detto il CEO Jensen Huang agli analisti in una conferenza sugli utili. La spesa globale per chip focalizzati sull’IA dovrebbe raggiungere i 53 miliardi di dollari quest’anno e raddoppiare entro i prossimi quattro anni, secondo il ricercatore di mercato Gartner.

Le continue carenze significano che le aziende devono innovare per mantenere l’accesso alle risorse di cui hanno bisogno. Alcune stanno mettendo insieme denaro per assicurarsi di non lasciare gli utenti in difficoltà. Ovunque, termini di ingegneria come “ottimizzazione” e “dimensioni del modello più piccole” sono di moda mentre le aziende cercano di ridurre le loro esigenze di GPU e gli investitori quest’anno hanno scommesso centinaia di milioni di dollari su startup il cui software aiuta le aziende a fare affidamento sulle GPU che hanno a disposizione. Una di queste startup, Modular, ha ricevuto richieste da oltre 30.000 potenziali clienti dal suo lancio a maggio, secondo il suo cofondatore e presidente, Tim Davis. La capacità di navigare la crisi nell’anno successivo potrebbe diventare un fattore determinante per la sopravvivenza nell’economia dell’IA generativa.

- Walmart farà cadere uova e gelato tramite drone per alcuni texani

- 5 Migliori Software per la Gestione dell’Inventario in India ...

- I migliori servizi di protezione dall’usurpazione di identità...

“Viviamo in un mondo con capacità limitata in cui dobbiamo usare la creatività per far combaciare le cose, mescolare le cose e bilanciare le cose”, afferma Ben Van Roo, CEO di Yurts, un’aiuto per la scrittura aziendale basato sull’IA. “Mi rifiuto di spendere un sacco di soldi per il calcolo.”

I fornitori di cloud computing sono molto consapevoli delle difficoltà dei loro clienti per quanto riguarda la capacità. La domanda crescente ha “colto un po’ di sorpresa l’industria”, afferma Chetan Kapoor, direttore del product management di AWS.

Il tempo necessario per acquisire e installare nuove GPU nei loro data center ha messo in ritardo i giganti del cloud e gli accordi specifici più richiesti aggiungono anche stress. Mentre la maggior parte delle applicazioni può funzionare con processori distribuiti in modo non troppo ravvicinato in tutto il mondo, l’addestramento dei programmi di IA generativa tende a funzionare meglio quando le GPU sono fisicamente raggruppate insieme, talvolta fino a 10.000 chip contemporaneamente. Questo lega le risorse disponibili come mai prima d’ora.

Kapoor afferma che il cliente tipico di generative AI di AWS utilizza centinaia di GPU. “Se un cliente specifico richiede 1.000 GPU domani, ci vorrà del tempo per poterle allocare”, afferma Kapoor. “Ma se sono flessibili, possiamo trovare una soluzione”.

AWS ha suggerito ai clienti di adottare servizi più costosi e personalizzati tramite l’offerta Bedrock, in cui le esigenze dei chip sono integrate nell’offerta senza che i clienti debbano preoccuparsi. Oppure i clienti potrebbero provare i chip AI unici di AWS, Trainium e Inferentia, che hanno registrato un aumento non specificato nell’adozione, secondo Kapoor. Adattare i programmi per funzionare su quei chip invece delle opzioni Nvidia è tradizionalmente stato un compito difficile, anche se Kapoor afferma che passare a Trainium ora richiede solo la modifica di due righe di codice software in alcuni casi.

Le sfide sono presenti anche altrove. Google Cloud non è riuscita a soddisfare la domanda del suo equivalente delle GPU interne, noto come TPU, secondo un dipendente non autorizzato a parlare con i media. Un portavoce non ha risposto a una richiesta di commento. L’unità di cloud di Microsoft Azure ha offerto rimborsi ai clienti che non utilizzano le GPU prenotate, secondo quanto riferito dal Information nell’aprile scorso. Microsoft ha rifiutato di commentare.

Le aziende cloud preferirebbero che i clienti riservino capacità per mesi o anni in modo che tali fornitori possano pianificare meglio i propri acquisti e installazioni di GPU. Ma le startup, che in genere hanno un capitale minimo e bisogni intermittenti mentre mettono a punto i loro prodotti, sono state riluttanti ad impegnarsi, preferendo piani di acquisto al momento del bisogno. Ciò ha portato ad un aumento degli affari per fornitori cloud alternativi, come Lambda Labs e CoreWeave, che quest’anno hanno raccolto quasi 500 milioni di dollari dagli investitori. Astria, la startup generatrice di immagini, è tra i loro clienti.

AWS non è esattamente felice di perdere terreno rispetto ai nuovi entranti nel mercato, quindi sta considerando opzioni aggiuntive. “Stiamo pensando a diverse soluzioni a breve e lungo termine per offrire l’esperienza che i nostri clienti cercano”, afferma Kapoor, rifiutandosi di entrare nei dettagli.

Le carenze dei fornitori cloud si stanno propagando ai loro clienti, che includono alcuni nomi importanti nel settore tecnologico. La piattaforma di social media Pinterest sta ampliando l’uso dell’IA per servire meglio gli utenti e gli inserzionisti, secondo il direttore tecnologico Jeremy King. L’azienda sta prendendo in considerazione l’utilizzo dei nuovi chip di Amazon. “Abbiamo bisogno di più GPU, come tutti”, dice King. “La carenza di chip è una cosa reale.”

OpenAI, che sviluppa ChatGPT e concede in licenza la tecnologia sottostante ad altre aziende, si basa molto sui chip di Azure per fornire i suoi servizi. Le carenze di GPU hanno costretto OpenAI a impostare limiti di utilizzo sugli strumenti che vende. Questo è stato un inconveniente per i clienti, come l’azienda che si occupa dell’assistente AI Jamie, che riassume l’audio delle riunioni utilizzando la tecnologia di OpenAI. Jamie ha ritardato i piani per un lancio pubblico di almeno cinque mesi, in parte perché voleva perfezionare il suo sistema, ma anche a causa dei limiti di utilizzo, afferma Louis Morgner, cofondatore della startup. Il problema non si è attenuato. “Manca solo qualche settimana al nostro lancio pubblico e dovremo poi monitorare attentamente quanto bene il nostro sistema può scalare, date le limitazioni dei nostri fornitori di servizi”, afferma Morgner.

“Il settore sta registrando una forte domanda di GPU”, afferma il portavoce di OpenAI, Niko Felix. “Continuiamo a lavorare per garantire che i nostri clienti API abbiano la capacità di soddisfare le loro esigenze.”

In questo momento, qualsiasi connessione che possa dare a una startup accesso a potenza di calcolo è vitale. Gli investitori, gli amici, i vicini: i dirigenti delle startup si affidano a una vasta gamma di relazioni per ottenere una maggiore potenza di AI. Astria, ad esempio, ha ottenuto capacità aggiuntiva presso AWS con l’aiuto di Emad Mostaque, CEO di Stability AI, che è un partner stretto di AWS e la cui tecnologia Astria utilizza.

La startup di contabilità Pilot, che utilizza la tecnologia di OpenAI per ordinare alcuni dati banali, ha ottenuto un accesso anticipato a GPT-4 dopo aver chiesto aiuto a amici universitari, dipendenti e venture capitalist con collegamenti a OpenAI. Non è chiaro se questi legami abbiano accelerato il passaggio di Pilot da una lista d’attesa, ma ora spende circa 1000 dollari al mese su OpenAI e tali connessioni potrebbero essere utili quando avrà bisogno di aumentare la sua quota, afferma il CEO Waseem Daher. “Se non sfrutti questa tecnologia generativa di AI, qualcun altro lo farà, ed è abbastanza potente da non voler rischiare”, afferma Daher. “Vuoi offrire i migliori risultati ai tuoi clienti e rimanere al passo con quello che sta accadendo nell’industria.”

Oltre a combattere per ottenere accesso a una maggiore potenza, le aziende stanno cercando di fare di meno con più. Le aziende che sperimentano l’IA generativa sono ora ossessionate dall'”ottimizzazione”, rendendo possibile l’elaborazione, con risultati soddisfacenti, sui GPU più convenienti. È analogo al risparmio di denaro abbandonando un vecchio frigorifero che consuma molta energia che conserva solo alcune bevande per un moderno mini-frigo che può funzionare principalmente con l’energia solare.

Le aziende stanno cercando di scrivere istruzioni migliori su come i chip dovrebbero elaborare le istruzioni di programmazione, cercando di riformattare e limitare la quantità di dati utilizzati per addestrare i sistemi di IA e quindi ridurre al minimo il codice di inferenza necessario per gestire il compito in questione. Ciò significa sviluppare più sistemi più piccoli, forse un generatore di immagini che produce animali e un altro che crea immagini di esseri umani e passare da uno all’altro a seconda della richiesta dell’utente.

Vengono anche pianificati i processi non sensibili al tempo per eseguirli quando la disponibilità delle GPU è maggiore e vengono fatti compromessi per bilanciare velocità ed economicità.

La startup di generazione di discorsi Resemble AI è soddisfatta di impiegare un decimo di secondo in più per elaborare una richiesta del cliente su un chip più vecchio se ciò comporta una spesa inferiore rispetto alle opzioni di fascia alta, senza differenze apprezzabili nella qualità audio, afferma il CEO Zohaib Ahmed. È anche disposto a guardare oltre Lambda e CoreWeave man mano che le loro condizioni diventano meno vantaggiose, con incentivi a fare impegni a lungo termine. CoreWeave ha rifiutato di commentare e Lambda non ha risposto a una richiesta di commento.

Resemble si è rivolto a FluidStack, un piccolo fornitore che accoglie prenotazioni di GPU per una settimana o un mese, e di recente si è unito al San Francisco Compute Group, un consorzio di startup che si impegna congiuntamente ad acquistare e dividere la capacità delle GPU. “L’ecosistema delle startup sta cercando di unirsi e cercare di capire ‘Come combattiamo, come lottiamo per il calcolo?’ Altrimenti, sarebbe un gioco davvero ingiusto. I prezzi sono troppo alti”, dice Ahmed.

Ogni lunedì mattina, dice, avverte una spruzzata di speranza sulla carenza. Un rappresentante delle vendite presso Lambda, il provider cloud, gli ha scritto chiedendo se Resemble vuole prenotare alcune delle nuove chip di Nvidia, l’H100. Il fatto che ci siano disponibilità è eccitante, dice Ahmed, ma queste chip sono state ampiamente disponibili solo da marzo ed è solo questione di tempo prima che le aziende che le testano perfezionino il codice per utilizzarle appieno. Nvidia lancerà la sua ultima e migliore, la GH200 di seconda generazione, l’anno prossimo. Poi il ciclo di carenza ripartirà da capo.