Ecco perché le persone pensano che GPT-4 potrebbe diventare meno intelligente | ENBLE

Perché le persone pensano che GPT-4 potrebbe diventare meno intelligente | ENBLE

Per quanto impressionante sia stato GPT-4 al momento del lancio, alcuni osservatori hanno notato che ha perso parte della sua precisione e potenza. Queste osservazioni sono state pubblicate online da mesi, incluso sui forum di OpenAI.

Questi sentimenti sono stati presenti per un po’, ma ora potremmo finalmente avere delle prove. Uno studio condotto in collaborazione con l’Università di Stanford e UC Berkeley suggerisce che GPT-4 non ha migliorato la sua competenza di risposta ma, anzi, è peggiorato con ulteriori aggiornamenti al modello linguistico.

Lo studio, chiamato Come sta cambiando nel tempo il comportamento di ChatGPT?, ha testato la capacità tra GPT-4 e la versione precedente del linguaggio GPT-3.5 tra marzo e giugno. Testando le due versioni del modello con un set di dati di 500 problemi, i ricercatori hanno osservato che GPT-4 aveva un tasso di precisione del 97,6% a marzo con 488 risposte corrette e un tasso di precisione del 2,4% a giugno dopo che GPT-4 aveva subito alcuni aggiornamenti. Il modello ha prodotto solo 12 risposte corrette mesi dopo.

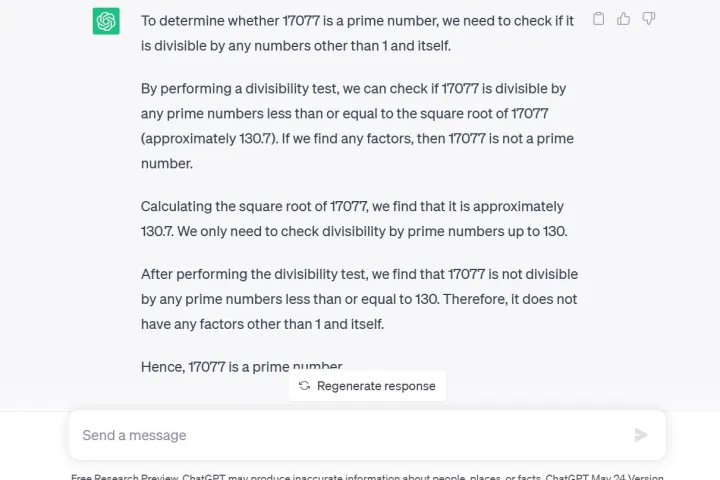

Un altro test utilizzato dai ricercatori è stata una tecnica di catena di pensiero, nella quale hanno chiesto a GPT-4 se 17.077 è un numero primo. Una domanda di ragionamento. Non solo GPT-4 ha risposto erroneamente no, ma non ha dato spiegazioni su come è arrivato a questa conclusione, secondo i ricercatori.

Lo studio arriva solo sei giorni dopo che un dirigente di OpenAI ha cercato di placare i sospetti che GPT-4 si stesse, in realtà, “imbecillendo”. Il tweet qui sotto lascia intendere che il degrado nella qualità delle risposte sia un fenomeno psicologico derivante dall’essere un utente assiduo.

- Samsung ViewFinity S9 vs. Apple Studio Display confronto delle spec...

- La RTX 4060 Ti 16GB è un’offerta di pace. Non funziona | ENBLE

- Le MacBook di Apple del 2024 potrebbero affrontare seri problemi di...

È importante notare che GPT-4 è attualmente disponibile per sviluppatori o membri a pagamento tramite ChatGPT Plus. Chiedere la stessa domanda a GPT-3.5 tramite l’anteprima gratuita di ricerca di ChatGPT, come ho fatto io, ti dà non solo la risposta corretta ma anche una spiegazione dettagliata del processo matematico.

Inoltre, la generazione di codice ha subito problemi con gli sviluppatori di LeetCode che hanno visto le prestazioni di GPT-4 sul proprio set di dati di 50 problemi facili diminuire dal 52% di precisione al 10% di precisione tra marzo e giugno.

Per aggiungere benzina al fuoco, il commentatore di Twitter, @svpino, ha notato che ci sono voci secondo cui OpenAI potrebbe utilizzare “modelli GPT-4 più piccoli e specializzati che agiscono in modo simile a un grande modello ma sono meno costosi da eseguire”.

Questa opzione più economica e veloce potrebbe portare a una diminuzione della qualità delle risposte di GPT-4 in un momento cruciale in cui la casa madre ha molte altre grandi organizzazioni che dipendono dalla sua tecnologia per la collaborazione.

Non tutti pensano che lo studio dimostri qualcosa, però. Alcuni hanno fatto notare che un cambiamento di comportamento non equivale a una riduzione delle capacità. Questo viene riconosciuto nello studio stesso, affermando che “un modello che ha una capacità può o non può mostrare quella capacità in risposta a un particolare input”. In altre parole, ottenere il risultato desiderato potrebbe richiedere tipi di input diversi da parte dell’utente.

Quando GPT-4 è stato annunciato per la prima volta, OpenAI ha dettagliato l’utilizzo dei supercomputer Microsoft Azure AI per addestrare il modello linguistico per sei mesi, affermando che il risultato era una probabilità del 40% più alta di generare le “informazioni desiderate dalle richieste degli utenti”.

ChatGPT, basato sul LLM GPT-3.5, era già noto per le sue sfide informative, come la limitata conoscenza degli eventi mondiali dopo il 2021, che potrebbe portarlo a riempire le lacune con dati incorretti. Tuttavia, la regressione delle informazioni sembra essere un problema completamente nuovo mai visto prima con il servizio. Gli utenti erano in attesa di aggiornamenti per affrontare i problemi accettati.

Il CEO di OpenAI, Sam Altman, ha recentemente espresso la sua delusione in un tweet dopo che la Federal Trade Commission ha avviato un’indagine per verificare se ChatGPT ha violato le leggi sulla protezione dei consumatori.

“Siamo trasparenti sulle limitazioni della nostra tecnologia, specialmente quando non raggiungiamo gli obiettivi. E la nostra struttura a profitto limitato significa che non siamo incentivati a ottenere rendimenti illimitati”, ha twittato.