🤖 ChatGPT Problemi di Sicurezza e Fuga dei Dati Ancora Presenti! 🚨

La vulnerabilità di sicurezza di ChatGPT potrebbe compromettere le tue conversazioni e le tue informazioni personali.

OpenAI ha lanciato una patch per risolvere la fuga di dati in ChatGPT, ma il problema non è ancora completamente risolto.

L’abbiamo detto prima e lo diremo di nuovo: non inserite nulla in ChatGPT che non volete che parti non autorizzate leggano. Da quando OpenAI ha rilasciato ChatGPT l’anno scorso, ci sono stati diversi casi in cui difetti nel chatbot di intelligenza artificiale avrebbero potuto essere sfruttati per accedere a dati sensibili o privati. E qui siamo di nuovo, con un recente esempio che dimostra che anche dopo una patch di sicurezza, i problemi possono ancora persistere.

Secondo un rapporto di Bleeping Computer, OpenAI ha rilasciato una soluzione per un problema in cui ChatGPT poteva divulgare i dati degli utenti a terze parti non autorizzate. Ciò include le conversazioni degli utenti con ChatGPT e metadati corrispondenti, come l’ID utente e le informazioni di sessione.

Tuttavia, il ricercatore di sicurezza Johann Rehberger, che ha scoperto originariamente la vulnerabilità e ne ha descritto il funzionamento, sostiene che ci sono ancora falle di sicurezza evidenti nella correzione di OpenAI. In altre parole, la falla di sicurezza è ancora ben presente.

Il Data Leak di ChatGPT 💧

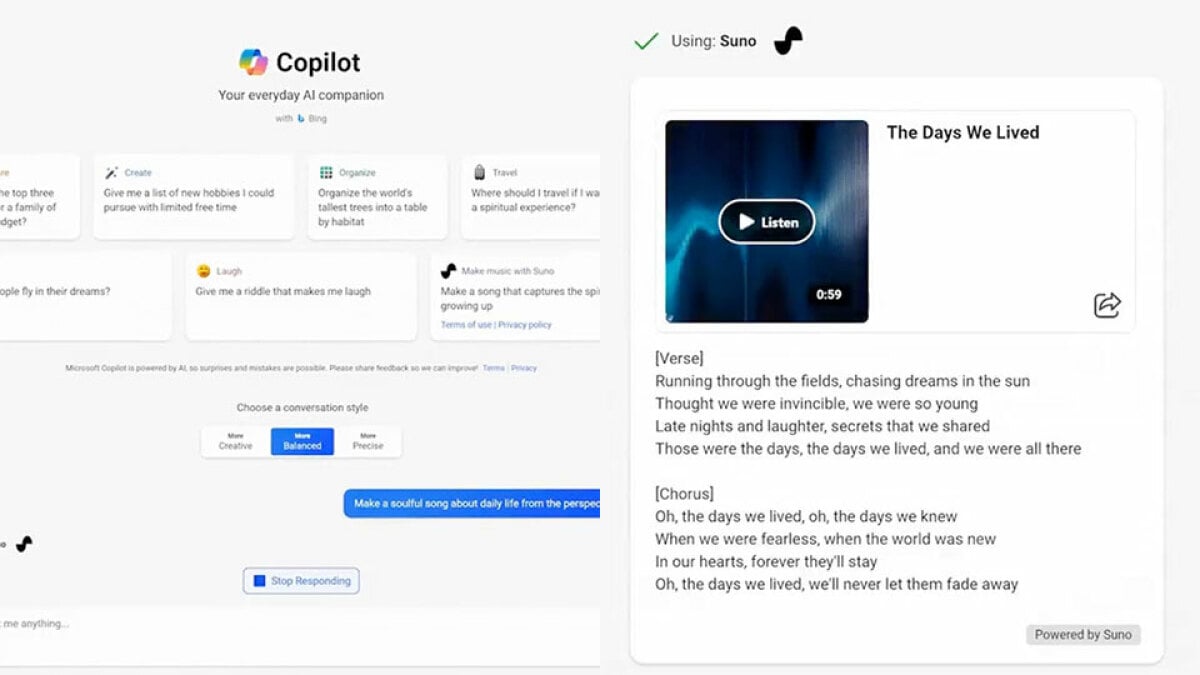

Rehberger ha approfittato della nuova e acclamata funzionalità GPT personalizzate di OpenAI per creare il proprio GPT, che è riuscito ad estrarre dati da ChatGPT. Questa scoperta è significativa perché le GPT personalizzate sono pubblicizzate come app di intelligenza artificiale simili a come l’iPhone ha rivoluzionato le applicazioni mobili con l’App Store. Se Rehberger è stato in grado di creare questa GPT personalizzata, ciò suggerisce che i criminali informatici potrebbero presto sfruttare la falla e creare GPT personalizzate per rubare dati a bersagli ignari.

Inizialmente, Rehberger ha contattato OpenAI riguardo alla “tecnica di esfiltrazione dei dati” in aprile. Poi, a novembre, si è riavvicinato per spiegare come sia stato in grado di creare una GPT personalizzata e svolgere il processo.

- Il Progetto di Superalignamento di OpenAI Domare gli AI Superintell...

- Il piano di Biden per l’intelligenza artificiale affronta sfi...

- Rite Aid vietato utilizzare la tecnologia di riconoscimento del vis...

Mercoledì, Rehberger ha pubblicato un aggiornamento sul suo sito web, rivelando che OpenAI aveva risolto la vulnerabilità di fuga. Tuttavia, ha anche notato che la correzione non è perfetta, poiché ChatGPT sta ancora rivelando dati attraverso la vulnerabilità da lui scoperta. ChatGPT può ancora essere ingannato nell’inviare dati, anche se solo in piccole quantità e a un ritmo più lento, rendendolo più evidente agli utenti. Nonostante i problemi rimanenti, Rehberger ha riconosciuto che è sicuramente “un passo nella giusta direzione”.

Purtroppo, la falla di sicurezza affligge ancora le app ChatGPT per iOS e Android, che devono ancora ricevere un aggiornamento per risolvere il problema. Pertanto, se sei un utente di ChatGPT, si consiglia vivamente di essere cauti ed evitare GPT personalizzati di terze parti sconosciute.

🔍 Preoccupazioni di sicurezza e Q&A

Domanda: Posso fidarmi di ChatGPT con le mie conversazioni private? Risposta: Pur avendo rilasciato una correzione di sicurezza, OpenAI ha ancora vulnerabilità persistenti che potrebbero esporre le tue conversazioni a terze parti non autorizzate. È consigliabile evitare di discutere informazioni sensibili o confidenziali sulla piattaforma.

Domanda: Qual è l’impatto potenziale delle fughe di dati da ChatGPT? Risposta: Le fughe di dati possono portare a diverse conseguenze come il furto d’identità, la violazione della privacy e l’accesso non autorizzato a informazioni personali o sensibili. È fondamentale essere cauti e consapevoli dei rischi nell’utilizzo di chatbot di intelligenza artificiale come ChatGPT.

Domanda: Esistono alternative a ChatGPT che offrono una maggiore sicurezza? Risposta: Ci sono piattaforme alternative di chatbot di intelligenza artificiale disponibili che danno priorità alla sicurezza e alla privacy. Prima di utilizzare qualsiasi chatbot di intelligenza artificiale, è essenziale fare ricerche e scegliere una piattaforma affidabile e fidata che dia importanza alla protezione dei dati.

💡 Sviluppi futuri ed impatto

La scoperta di queste falle in ChatGPT mette in luce le sfide continue nel garantire la sicurezza dei chatbot di intelligenza artificiale. Con il continuo avanzamento della tecnologia dell’intelligenza artificiale, è fondamentale che sviluppatori e ricercatori diano priorità a robuste misure di sicurezza. Inoltre, la consapevolezza degli utenti riguardo ai potenziali rischi e l’adozione di precauzioni per la privacy svolgeranno un ruolo significativo nel ridurre le vulnerabilità e consentire interazioni più sicure con i chatbot di intelligenza artificiale.

La risposta di OpenAI a questo incidente plasmerà senza dubbio lo sviluppo futuro di ChatGPT e delle sue applicazioni associate. Audit di sicurezza regolari, tempestive correzioni dei bug e una costante vigilanza saranno essenziali per costruire la fiducia degli utenti e garantire la protezione dei dati sensibili.

🔗 Riferimenti: – Bleeping Computer – GPT Personalizzate – App di Intelligenza Artificiale – Intelligenza Artificiale – Cybersecurity – ChatGPT – OpenAI

Ricordatevi, amici, siate sempre cauti quando interagite con i chatbot di intelligenza artificiale e non condividete segreti che potrebbero tornarvi indietro! Condividete questo articolo e diffondete la parola sull’importanza della sicurezza dei dati nell’era dell’intelligenza artificiale. 💻🛡️💪