La nuova versione di ChatGPT finalmente supera la barriera del testo | ENBLE

New version of ChatGPT breaks text barrier | ENBLE

OpenAI sta introducendo nuove funzionalità per ChatGPT che permetteranno l’esecuzione di prompt con immagini e direttive vocali oltre al testo.

Il marchio di intelligenza artificiale ha annunciato lunedì che queste nuove funzioni saranno disponibili nelle prossime due settimane agli utenti di ChatGPT Plus e Enterprise. La funzione vocale è disponibile su iOS e Android in modalità opt-in, mentre la funzione immagini è disponibile su tutte le piattaforme di ChatGPT. OpenAI ha dichiarato di avere intenzione di ampliare la disponibilità delle funzioni immagini e voce anche agli utenti non paganti dopo il rollout graduale.

La chat vocale funziona come una conversazione uditiva tra l’utente e ChatGPT. Basta premere il pulsante e fare la domanda. Dopo aver elaborato le informazioni, il chatbot fornisce una risposta in forma di discorso uditivo anziché testuale. Il processo è simile all’utilizzo di assistenti virtuali come Alexa o Google Assistant e potrebbe essere l’inizio di una ristrutturazione completa degli assistenti virtuali nel loro complesso. L’annuncio di OpenAI arriva pochi giorni dopo che Amazon ha rivelato una funzione simile in arrivo per Alexa.

Per implementare la comunicazione vocale con ChatGPT, OpenAI utilizza un nuovo modello di sintesi vocale in grado di generare “audio simile a quello umano a partire solo da testo e pochi secondi di registrazione vocale campione”. Inoltre, il suo modello Whisper può “trascrivere le parole pronunciate in testo”.

OpenAI è consapevole dei problemi che potrebbero sorgere a causa della potenza di questa funzione, inclusa “la possibilità che attori malevoli si fingano figure pubbliche o commettano frodi”.

- Niente più GPU? Ecco come potrebbe essere DLSS 10 di Nvidia | ENBLE

- Fedora 39 beta offre la distribuzione Linux con le migliori prestaz...

- L’investimento di Amazon nelle capacità di intelligenza artif...

Questo è uno dei principali motivi per cui l’azienda intende limitare l’utilizzo delle nuove funzioni a “casi d’uso specifici e partnership”. Anche quando le funzioni saranno più ampiamente disponibili, saranno accessibili principalmente agli utenti più privilegiati, come gli sviluppatori.

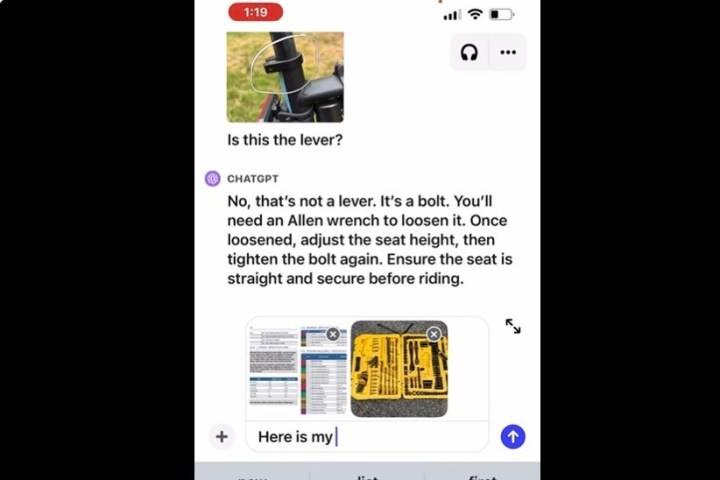

La funzione immagini consente di catturare un’immagine e inserirla in ChatGPT insieme alla domanda o al prompt. È possibile utilizzare lo strumento di disegno dell’app per chiarire la risposta e avere una conversazione interattiva con il chatbot fino a risolvere il problema. Questo è simile alla nuova funzione Copilot di Microsoft in Windows, che si basa sul modello di OpenAI.

OpenAI ha anche riconosciuto le sfide di ChatGPT, come il suo problema di allucinazione persistente. Quando si combina con la funzione immagini, il marchio ha deciso di limitare alcune funzionalità, come “la capacità del chatbot di analizzare e fare affermazioni dirette sulle persone”.

ChatGPT è stato presentato per la prima volta come uno strumento di sintesi vocale alla fine dell’anno scorso; tuttavia, OpenAI ha rapidamente ampliato le sue capacità. Il chatbot originale basato sul modello di linguaggio GPT-3 è stato successivamente aggiornato a GPT-3.5 e ora a GPT-4, che è il modello che riceverà la nuova funzione.

Quando GPT-4 è stato lanciato per la prima volta a marzo, OpenAI ha annunciato varie collaborazioni aziendali, come Duolingo, che ha utilizzato il modello di intelligenza artificiale per migliorare l’accuratezza delle lezioni di ascolto e basate sulla pronuncia nell’app per l’apprendimento delle lingue. OpenAI ha collaborato con Spotify per tradurre i podcast in altre lingue preservando il suono della voce del podcaster. L’azienda ha anche parlato del suo lavoro con l’app mobile Be My Eyes, che aiuta le persone non vedenti e ipovedenti. Moltissime di queste app e servizi erano già disponibili prima dell’aggiornamento immagini e voce.