La nuova ondata di intelligenza artificiale è in arrivo e sarà potente

La nuova ondata di intelligenza artificiale sarà potente.

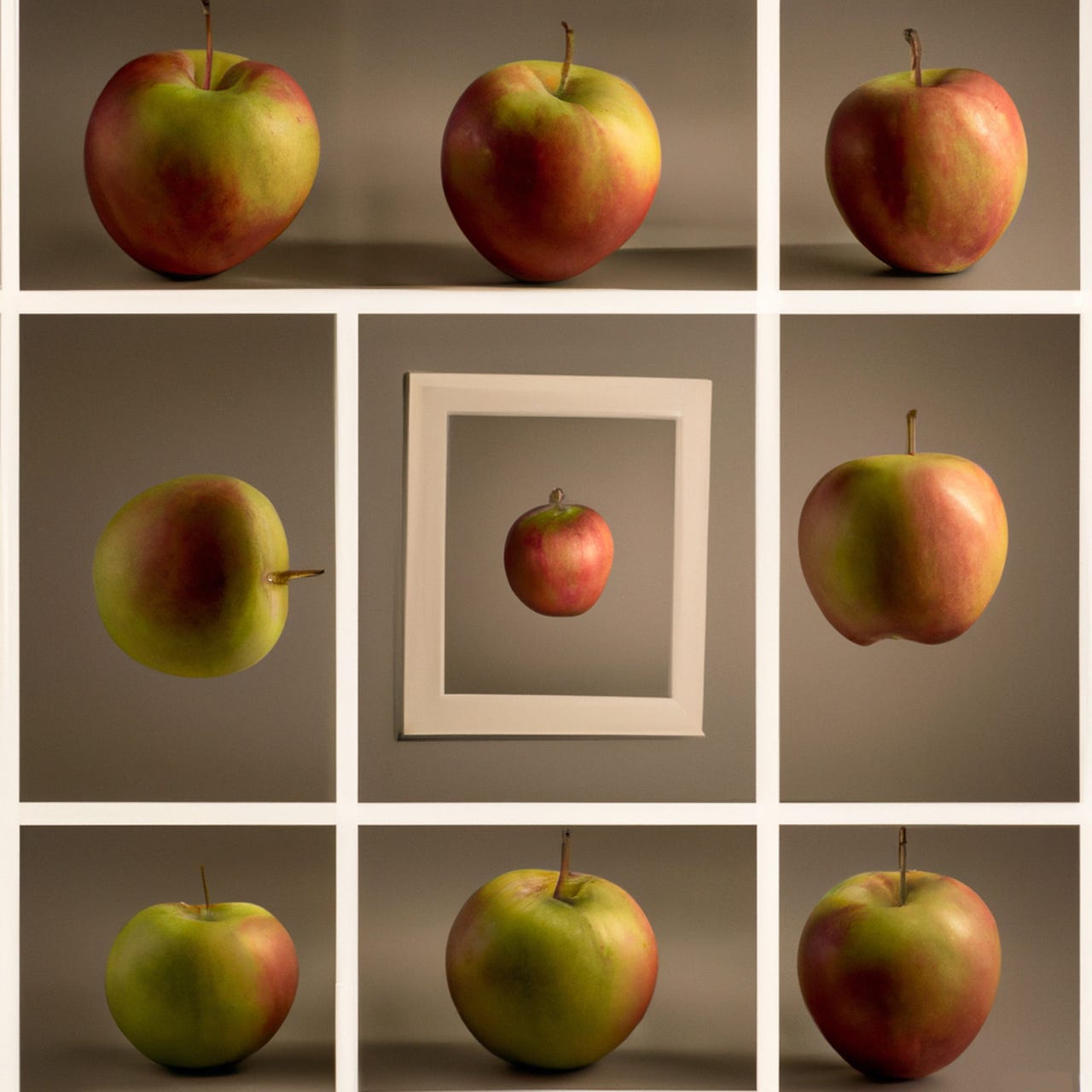

La cosiddetta multi-view è un modo per collegare due segnali diversi considerando le informazioni che condividono sullo stesso oggetto nonostante le differenze. La multi-view potrebbe aprire la strada a macchine in grado di avere una comprensione più ricca della struttura del mondo, contribuendo forse all’obiettivo di macchine in grado di “ragionare” e “pianificare”.

L’intelligenza artificiale nella sua forma più efficace – cose come ChatGPT o AlphaFold di DeepMind per prevedere le proteine – è stata intrappolata in una dimensione sorprendentemente stretta: l’IA vede le cose solo da un lato, come una parola, come un’immagine, come una coordinata nello spazio – come qualsiasi tipo di dati, ma solo uno alla volta.

In breve tempo, le reti neurali sono pronte a espandersi in modo significativo con una fusione di forme di dati che esamineranno la vita da molteplici prospettive. È un importante sviluppo, perché potrebbe fornire alle reti neurali una base più solida per comprendere come il mondo si tiene insieme, come le cose si connettono, il che potrebbe essere una tappa importante verso programmi che un giorno potranno “ragionare” e “pianificare” sul mondo.

Inoltre: Meta presenta il traduttore vocale ‘Seamless’

La prossima ondata di dati multi-laterali ha le sue radici in anni di studio da parte dei ricercatori di apprendimento automatico e viene generalmente chiamata “multi-view” o, alternativamente, fusione di dati. Esiste persino una rivista accademica dedicata all’argomento, chiamata Information Fusion, pubblicata dal gigante dell’editoria accademica Elsevier.

- Dodici nazioni esortano i giganti dei social media a contrastare lo...

- Un kit auto Roadmaster Bluetooth Hands-Free gratuito viene offerto ...

- Primo summit sulla sicurezza dell’IA al Bletchley Park, sede ...

L’idea profonda della fusione di dati è che qualsiasi cosa nel mondo che si sta cercando di esaminare ha molti lati contemporaneamente. Una pagina web, ad esempio, ha sia il testo che si vede a occhio nudo, sia il testo ancorato che collega a quella pagina, o addirittura una terza cosa, il codice HTML e CSS sottostante che rappresenta la struttura della pagina.

Un’immagine di una persona può avere sia un’etichetta con il nome della persona, sia i pixel dell’immagine. Un video ha un fotogramma video ma anche l’audio che accompagna quel fotogramma.

I programmi di intelligenza artificiale odierni trattano tali dati diversi come pezzi separati di informazioni sul mondo, con poca o nessuna connessione tra di loro. Anche quando le reti neurali gestiscono diversi tipi di dati, come testo e audio, il massimo che fanno è elaborare contemporaneamente questi insiemi di dati, senza collegare esplicitamente i diversi tipi di dati con la comprensione che sono punti di vista dello stesso oggetto.

Ad esempio, Meta Properties – proprietaria di Facebook, Instagram e WhatsApp – ha presentato martedì il suo ultimo sforzo nella traduzione automatica, una prova d’arte nell’uso di molteplici modalità di dati. Il programma, SeamlessM4T, è addestrato contemporaneamente su dati vocali e dati testuali e può generare sia testo che audio per qualsiasi compito.

Ma SeamlessM4T non percepisce ogni unità di ogni segnale come un aspetto dello stesso oggetto.

Inoltre: L’AI di Meta per la generazione di immagini dice che potrebbe bastare solo il linguaggio

Questa visione frammentata delle cose sta cominciando a cambiare. In un articolo pubblicato di recente dal professor assistente e fellow della facoltà dell’Università di New York Ravid Shwartz-Ziv e dal capo scienziato dell’IA di Meta, Yann LeCun, i due discutono dell’obiettivo di utilizzare la multi-view per arricchire le reti neurali di deep learning rappresentando gli oggetti da molteplici prospettive.

Gli oggetti sono frammentati in segnali non correlati nelle reti neurali profonde di oggi. La prossima ondata di multi-modalità, che utilizza immagini, suoni, testo e punti di vista a nuvola, reti grafiche e molti altri tipi di segnali, potrebbe iniziare a creare un modello più ricco della struttura delle cose.

Nel documento altamente tecnico e piuttosto teorico, pubblicato sul server di pre-stampa arXiv ad aprile, Shwartz-Ziv e LeCun scrivono che “il successo del deep learning in vari ambiti applicativi ha portato a un crescente interesse per i metodi di deep multiview, che hanno mostrato risultati promettenti”.

La multi-view si sta dirigendo verso un momento di destino, poiché le reti neurali sempre più grandi di oggi – come SeamlessM4T – assumono sempre più modalità, note come IA “multi-modale”.

Inoltre: I migliori chatbot AI del 2023: ChatGPT e alternative

Il futuro dell’intelligenza artificiale generativa, come i programmi ChatGPT e Stable Diffusion, combinerà una moltitudine di modalità in un unico programma, includendo non solo testo, immagini e video, ma anche nuvole di punti e grafi di conoscenza, persino dati di bioinformatica e molte altre visualizzazioni di una scena o di un oggetto.

Le molte diverse modalità offrono potenzialmente migliaia di “visualizzazioni” delle cose, visualizzazioni che potrebbero contenere informazioni mutuali, che potrebbero essere un approccio molto ricco per comprendere il mondo. Ma solleva anche delle sfide.

La chiave per le reti neurali profonde multi-view è un concetto che Shwartz-Ziv e altri hanno ipotizzato e che è conosciuto come “information bottleneck” (collo di bottiglia dell’informazione). Il collo di bottiglia dell’informazione diventa problematico all’aumentare del numero di modalità.

Un collo di bottiglia dell’informazione è un concetto chiave nell’apprendimento automatico. Nei livelli nascosti di una rete profonda, si suppone che l’input della rete venga ridotto a quelle cose più essenziali per produrre una ricostruzione dell’input, una forma di compressione e decompressione.

In un collo di bottiglia dell’informazione, più input vengono combinati in una “rappresentazione” che estrae i dettagli salienti condivisi dagli input come visualizzazioni diverse dello stesso oggetto. In una seconda fase, quella rappresentazione viene poi ridotta a una forma compressa che contiene solo gli elementi essenziali dell’input necessari per prevedere un output che corrisponda a quell’oggetto. Quel processo di accumulo di informazioni mutuali, e poi di rimozione o compressione di tutto tranne gli elementi essenziali, è il collo di bottiglia dell’informazione.

La sfida per il multi-view in grandi reti multi-modalità è come sapere quali informazioni di tutte le diverse visualizzazioni sono essenziali per i molti compiti che una rete neurale gigante svolgerà con tutte quelle diverse modalità.

Inoltre: Puoi creare il tuo chatbot AI con questo strumento drag-and-drop

Come esempio semplice, una rete neurale che svolge un compito basato sul testo come ChatGPT, producendo frasi di testo, potrebbe avere problemi quando deve anche, ad esempio, produrre immagini, se i dettagli rilevanti per quest’ultimo compito sono stati scartati durante la fase di compressione.

Come scrivono Shwartz-Ziv e LeCun, “[S]eparare le informazioni in componenti rilevanti e non rilevanti diventa difficile, portando spesso a prestazioni subottimali.”

Non c’è ancora una risposta chiara a questo problema, dichiarano gli studiosi. Richiederà ulteriori ricerche; in particolare, ridefinire il multi-view da qualcosa che include solo due visualizzazioni diverse di un oggetto a possibilmente molte visualizzazioni.

“Per garantire l’ottimalità di questo obiettivo, dobbiamo ampliare l’assunzione di multi-view per includere più di due visualizzazioni”, scrivono. In particolare, l’approccio tradizionale al multi-view assume “che le informazioni rilevanti siano condivise tra tutte le diverse visualizzazioni e attività, il che potrebbe essere eccessivamente restrittivo”, aggiungono. Potrebbe essere che le visualizzazioni condividano solo alcune informazioni in alcuni contesti.

Inoltre: Ecco come l’intelligenza artificiale generativa migliorerà l’economia del gig

“Di conseguenza”, concludono, “definire e analizzare una versione più raffinata di questa soluzione ingenua è essenziale.”

Senza dubbio, la crescita della multi-modalità spingerà la scienza del multi-view a ideare nuove soluzioni. L’esplosione della multi-modalità nella pratica porterà a nuove scoperte teoriche per l’IA.