L’IA generativa supererà di gran lunga ciò che ChatGPT può fare. Ecco tutto su come si sviluppano le tecnologie

La generative AI supererà ChatGPT in modo significativo. Ecco tutto sullo sviluppo delle tecnologie.

Più di tutti i grandi successi dell’intelligenza artificiale – vincere a scacchi, prevedere la piegatura delle proteine, etichettare gatti e cani – la forma di AI conosciuta come generative AI ha affascinato l’immaginazione globale.

ChatGPT è diventato il programma software a crescita più rapida nella storia a gennaio, raggiungendo cento milioni di utenti in meno di due mesi dal suo debutto pubblico. Ha generato numerosi rivali, sia programmi proprietari come Google’s Bard, sia alternative open-source come Koala dell’Università della California a Berkeley. La frenesia di eccitazione ha provocato una corsa agli armamenti tra i giganti tecnologici Microsoft e Google e i loro omologhi, e un aumento degli affari del produttore di chip di intelligenza artificiale Nvidia.

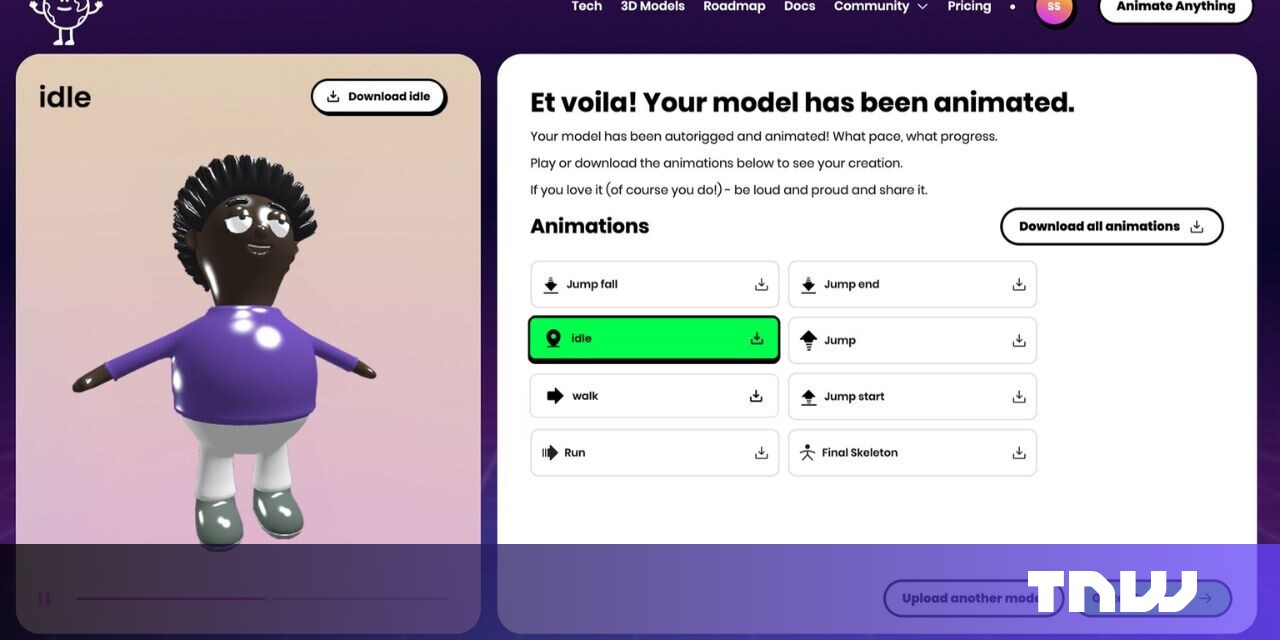

L’eccitazione per i grandi modelli di linguaggio ha portato alla fioritura di numerosi programmi proprietari e open-source di scala sempre maggiore solo per il testo. Il diagramma proviene dall’articolo del 2023 “Emotional Intelligence of Large Language Models” di Xuena Wang e colleghi dell’Università Tsinghua.

Tutta questa fervente attività ha radici nel semplice fatto che, a differenza dei programmi di intelligenza artificiale del passato, che producevano principalmente un punteggio numerico – un “1” per una foto di un gatto, uno “0” per una foto di un cane – ChatGPT e programmi per immagini come Stable Diffusion di Stability.ai e DALL-E di OpenAI riproducono qualcosa del mondo.

Caratteristica speciale

- Apple Pencil 3 potrebbe avere punte magnetiche per diversi stili di...

- Apple inizia a vendere HomePod 2023 ricondizionato in alcuni paesi ...

- Apple Watch originale è ora obsoleto, incluso il modello in oro da ...

L’ascesa della generative AI

Una nuova ondata di strumenti di intelligenza artificiale ha conquistato il mondo e ci ha dato una visione di un nuovo modo di lavorare e trovare le informazioni che possono semplificare il nostro lavoro e la nostra vita. Mostreremo i modi in cui strumenti come ChatGPT e altri software di intelligenza artificiale generativa stanno avendo un impatto sul mondo, come sfruttarne il potere, nonché i rischi potenziali.

Producendo un paragrafo, un’immagine o persino lo scheletro di un programma per computer, tali programmi stanno riflettendo le creazioni della società.

L’aspetto della riflessione aumenterà in modo drammatico in un periodo molto breve. I programmi generativi di oggi sembreranno primitivi in confronto alle capacità dei programmi che saranno diffusi alla fine di quest’anno, poiché produrranno molti più tipi di cose.

Passando a modalità multiple

Ciò che gli informatici chiamano modalità miste o “multi-modalità” assumerà un ruolo centrale, poiché i programmi fonderanno testo, immagini, “cloud di punti” dello spazio fisico, suoni, video e funzioni intere del computer come applicazioni intelligenti.

La modalità mista renderà possibili programmi molto più capaci e contribuirà a un obiettivo a lungo sognato di apprendimento continuo. Potrebbe persino favorire il raggiungimento dell’obiettivo di un’intelligenza artificiale “incarnata” dando una spinta alla robotica.

“ChatGPT è stato creato per il divertimento e fa molte cose molto bene, ma è sorta di una dimostrazione”, ha detto Naveen Rao, fondatore di MosaicML, una startup di intelligenza artificiale, in un’intervista con ENBLE. “Ora dobbiamo iniziare a pensare a come migliorare se lo utilizzo per uno scopo specifico”.

Rao, la cui azienda è stata acquisita da Databricks per la sua esperienza nell’esecuzione di programmi di intelligenza artificiale, ora ricopre il ruolo di vicepresidente di generative AI presso Databricks.

Inoltre: l’AI image generator di Meta sostiene che il linguaggio potrebbe essere tutto ciò di cui hai bisogno

Parte di questo miglioramento sarà rendere la generative AI qualcosa di più di un semplice “Copilot” personale, come GitHub Copilot di Microsoft, che assiste un singolo individuo nella digitazione di una richiesta di chat. I programmi diventeranno invece collaborativi, per i team, ha detto Emad Mostaque, fondatore e CEO di Stability.ai, in un’intervista con ENBLE.

“Molta intelligenza artificiale viene utilizzata solo come uno-a-uno, o è un agente autonomo”, ha detto Mostaque. “Al momento siamo nella fase dell’iPhone 2G, in cui è solo una modalità singola e si copia e incolla, mentre penso che la cosa più eccitante sia come possiamo collaborare meglio e raccontare storie migliori con essa, e questo non è un impegno solitario”.

Una delle cose che è “fondamentalmente mancante”, ha detto Rao di Databricks, “è la multi-modalità del mondo”, dato che “i grandi modelli di linguaggio sono molto unidimensionali nel senso che vedono il mondo solo attraverso il testo.”

Le modalità si riferiscono alla natura dell’input e dell’output, come il testo, l’immagine o il video. Sono possibili diverse modalità e sono state esplorate con una crescente diversità, perché gli stessi concetti di base che guidano ChatGPT possono essere applicati a qualsiasi tipo di input.

“La multi-modalità è sicuramente la strada da seguire”, ha detto Mostaque. “Avrai bisogno di modelli di ogni tipo, e forse se li unisci insieme, sarà incredibile.”

“Le cose riguardanti solo il linguaggio hanno avuto molto successo ed eccitazione, e quindi i media si concentrano su quello, ma le persone stanno lavorando seriamente su altre cose”, ha detto Jim Keller, un rinomato progettista di chip informatici che è CEO della startup Tenstorrent, in un’intervista con ENBLE. Keller sta scommettendo sulla prospettiva che la gestione delle modalità miste sarà una delle grandi richieste dell’IA in futuro.

Una macchina per qualsiasi tipo di dati

In un grande modello di linguaggio, che è il cuore della tecnologia di ChatGPT, il testo viene convertito in un token, una rappresentazione matematica quantificata. La macchina deve quindi trovare ciò che manca dalle parti mascherate di una frase intera o dalla parte successiva di una frase. È l’atto di ricreazione che porta alla generazione dei paragrafi che ChatGPT produce.

Allo stesso modo, nel caso delle immagini, il diffusione ampiamente utilizzato – reso popolare dalla versione Stable Diffusion di Stability.ai – corrompe le immagini con rumore, e l’atto di ricreare l’immagine originale addestra una rete neurale a generare immagini ad alta fedeltà.

Inoltre: L’IA generativa può risolvere il più grande problema irrisolto dell’informatica?

Gli stessi processi di recupero di ciò che manca o è corrotto si stanno diffondendo rapidamente in numerose modalità o tipi di dati. Ad esempio, in un recente numero della rivista Nature, il biologo David Baker dell’Università di Washington e il suo team hanno corrotto le sequenze di aminoacidi delle proteine tramite un processo chiamato RFdiffusion. Quel processo addestrerà una rete neurale a produrre una proteina, in simulazione, una nuova proteina sintetica che ha proprietà desiderate.

Una tale sintesi può ridurre drasticamente il numero di proteine che devono essere inventate e testate per ottenere nuovi anticorpi per le malattie. (L’articolo di Nature è dietro un paywall, ma una versione gratuita è disponibile sul server dei file bioRxiv. Maggiori informazioni possono essere trovate sul sito web del Baker Lab.)

Il processo RFdiffusion sviluppato dal Baker Lab dell’Istituto per la Progettazione delle Proteine dell’Università di Washington corrompe le sequenze di aminoacidi per poi sintetizzare una nuova struttura proteica allo stesso modo in cui la diffusione delle immagini crea immagini.

“Abbiamo laboratori per ogni modalità”, ha detto Mostaque di Stability.ai, che afferma che la sua azienda e OpenAI sono “le uniche due aziende multi-modal indipendenti”, al di fuori dei giganti tecnologici come Google. Tale multi-modalità include un laboratorio presso Stability.ai solo per l’audio, ha detto, un laboratorio solo per la generazione di codice, persino un laboratorio per la biologia che lavora su cose come la ricreazione di immagini fMRI utilizzando la tecnologia Stable Diffusion.

La magia, però, accade quando vengono combinati più modalità. La “svolta”, ha detto Mostaque, è avvenuta lo scorso anno nel lavoro di Katherine Crowson e diversi altri ricercatori che hanno addestrato una rete neurale generatrice di immagini a perfezionare continuamente il loro output finché l’output non soddisfacesse una richiesta basata su testo. Hanno scoperto che il rielaborare le immagini per corrispondere al contenuto “semantico” del testo migliora la qualità dell’immagine. Crowson è ora presso Stability.ai, ha notato Mostaque.

Questo lavoro di immagine-testo sta procedendo rapidamente in numerose istituzioni. I ricercatori di intelligenza artificiale presso Meta hanno proposto una combinazione di macchine per il testo e le immagini chiamata CM3Leon che eccelle non solo nell’emettere testo o immagini, ma nel svolgere compiti che coinvolgono entrambi contemporaneamente, come identificare oggetti in un’immagine data o generare didascalie da un’immagine data.

La rete neurale CM3Leon di Meta mescola immagini e testo per svolgere molteplici compiti, come descrivere dettagliatamente un’immagine data o modificare un’immagine data con precisione. È descritto nel documento del 2023, “Scaling Autoregressive Multi-Modal Models: Pre-training and Instruction Tuning,” di Lilu Yu e colleghi presso Meta AI.

Un quadro più completo del mondo

La combinazione di diverse modalità inizia a creare un quadro più completo del mondo per la rete neurale. Rao di Databricks cita il concetto di neuroscienze chiamato “stereognosi”, che significa conoscere il mondo attraverso il senso del tatto. Se qualcuno ti chiede quanto denaro hai in tasca, puoi sentire le monete e capire il loro valore tramite la dimensione e il peso senza vederle. “Ho una rappresentazione del mondo e degli oggetti che sono rappresentati effettivamente in diverse modalità”, ha detto. “Se posso imparare concetti che abbracciano diverse modalità, allora abbiamo fatto qualcosa di interessante”.

L’idea che i diversi sensi contribuiscano alla comprensione è riscontrata negli esperimenti multimodali in corso. La ricerca è attiva su come creare reti neurali chiamate “backbone” in grado di combinare una vasta gamma di modalità, e mostrano interessanti benefici in termini di prestazioni.

Recentemente, gli studiosi dell’Università Carnegie Mellon hanno proposto quello che definiscono un “Trasformatore Multimodale ad Alta Modalità”, che combina non solo testo, immagini, video e discorsi, ma anche informazioni di tabelle di database e dati di serie temporali. L’autore principale, Paul Pu Liang, e i suoi colleghi riferiscono di aver osservato “un comportamento di scalabilità cruciale” nella rete neurale a 10 modalità. “Le prestazioni continuano a migliorare con l’aggiunta di ogni modalità, e si trasferiscono anche a modalità e compiti completamente nuovi”.

L’articolo del 2023 dell’Università Carnegie Mellon, “Trasformatore Multimodale ad Alta Modalità” di Paul Liang e colleghi, combina non solo testo, immagini, video e discorsi, ma anche informazioni di tabelle di database e dati di serie temporali.

Gli studiosi Yiyuan Zhang e colleghi del Laboratorio Multimediale dell’Università Cinese di Hong Kong hanno aumentato il numero di modalità a una dozzina nel loro “Meta-Transformer”. Il suo modello di punti nubi rappresenta la visione 3D, mentre i dati di rilevamento iperspettrale rappresentano l’energia elettromagnetica riflessa dal terreno nelle immagini panoramiche.

Il Meta-Transformer rappresenta il futuro dell’intelligenza artificiale generativa, con una grande quantità di dati di diversi tipi che vengono fusi per avere una percezione più completa di ciò che viene prodotto come output. Viene esplorato nell’articolo del 2023, “Meta-Transformer: Un Framework Unificato per l’Apprendimento Multimodale”, di Yiyuan Zhang e colleghi del Laboratorio Multimediale dell’Università Cinese di Hong Kong e dell’OpenGVLab presso il Laboratorio di Intelligenza Artificiale di Shanghai.

Creare un libro di storie da diverse modalità

Il vantaggio immediato della multimodalità sarà semplicemente quello di arricchire l’output di applicazioni come ChatGPT in modi che vanno ben oltre la modalità “demo”. Un libro per bambini, un libro con passaggi di testo combinati con immagini che illustrano il testo, è un esempio immediato. Combinando le caratteristiche del linguaggio e delle immagini, è possibile controllare in modo più sottile il tipo di immagini create dal processo di diffusione.

Come spiegato dagli scienziati di Google e l’autore principale Wan-Duo Kurt Ma dell’Università Victoria di Wellington in Nuova Zelanda, un processo chiamato “diffusione diretta” può spostare il gatto, o un castello, o un uccello, attraverso varie scene, creando una serie di immagini che permettono un controllo maggiore e transizioni come in una narrazione.

Una tecnica chiamata diffusione diretta può spostare un oggetto, come un gatto, un castello o un uccello, attraverso varie scene, creando una serie di immagini che permettono un controllo maggiore e transizioni come in una narrazione. È descritta nell’articolo del 2023 “Diffusione Diretta: Controllo Diretto della Posizione degli Oggetti Attraverso Orientamento dell’Attenzione” di Wan-Duo Kurt Ma e colleghi dell’Università Victoria di Wellington e della Ricerca di Google.

Allo stesso modo, Hyeonho Jeong della Sungkyunkwan University della Corea, insieme agli studiosi del Korea Advanced Institute of Science & Technology, ha proposto un’ulteriore variante della diffusione, chiamata “diffusione latente”, che è stata descritta in un recente articolo. Essi sostengono che questa tecnica permette di ottenere molti più dettagli di un’immagine a un livello di granularità basso.

Il risultato è la capacità di generare libri di storie in cui un personaggio si muove attraverso diverse situazioni immagine per immagine, come aggiungere manopole alla richiesta di testo per selezionare diverse situazioni. La coerenza dell’oggetto tra le immagini è ciò che chiamano “Iniezione Coerente Iterativa dell’Identità”.

Una tecnica chiamata diffusione latente estende la creazione di immagini con ciò che i suoi inventori chiamano “Iniezione dell’Identità” per scrivere il movimento di un personaggio attraverso le immagini di un libro di storie.

Come nel caso della sintesi delle proteine al Baker Lab, le applicazioni della multimodalità possono diventare piuttosto sorprendenti. Un altro recente articolo di Chenyu Tang e colleghi del Dipartimento di Ingegneria dell’Università di Cambridge propone di costruire un “gemello digitale”, una simulazione computerizzata del corpo umano, con tutti gli organi e i tessuti resi visibili e i flussi di sangue e altre cose rappresentati combinando dati provenienti da diversi strumenti medici nello stesso processo di diffusione stabile.

“Entrambi i sensori di movimento (come accelerometri, sensori EMG, ecc.) e i sensori biochimici (per rilevare biomarcatori corrispondenti a malattie, come sensori di saliva, sensori di sudore, ecc.) possono produrre output specifici per il paziente,” hanno scritto gli autori. “Sebbene questi output abbiano pattern distinti, tutti corrispondono alla stessa malattia.”

Il “doppio digitale” del corpo umano potrebbe essere abilitato combinando dati provenienti da strumenti medici multipli nel medesimo processo di diffusione stabile. Il diagramma rappresenta la “mappa di percorso a cinque livelli per il doppio digitale del corpo”, come si può vedere nell’articolo del 2023 intitolato “Piano Master del Doppio Digitale del Corpo Umano” di Chenyu Tang e colleghi dell’Università di Cambridge.

Maestri speciali delle modalità

Secondo Mostaque di Stability.ai, sarà importante sia il modo in cui le modalità vengono messe insieme che quali vengono utilizzate. “L’ultima parte sarà la composizione, poiché questi mattoncini che costruiamo vengono inseriti in un software adeguato che è incentrato sull’IA, che ridefinisce tutta questa creazione, consumo e flussi di processo con questi nuovi strumenti interessanti,” ha detto.

Anche se possono essere richiamati modelli massicci come il PaLM LLM di Google o il GPT-4, molto spesso si verificherà una miscelazione di modalità come un’orchestrazione di componenti, ha detto. “Come si combinano modelli in modi davvero interessanti e si fanno lavorare insieme molti modelli diversi per raggiungere i risultati desiderati per potenziarli davvero?”

Anche se il PaLM e il GPT-4 possono essere potenti, ha detto, ci sono ampie prove che “molti modelli specializzati possono superare” i programmi più grandi. Di conseguenza, “Penso che avremo molti modelli specialistici per le diverse modalità,” ha detto, un processo di “de-costruzione” della tecnologia nei suoi ruoli appropriati, “e poi alcuni modelli multi-modalità che possono fare tutto e vengono richiamati al momento appropriato per la cosa appropriata.”

La robotica è la prossima frontiera dell’IA

La mescolanza delle modalità è significativa nel campo dell’IA incarnata, sotto forma di robotica.

Sergey Levine, professore associato nel dipartimento di ingegneria elettrica dell’Università della California a Berkeley, ha detto a ENBLE che per quanto riguarda l’IA generativa, i sistemi nella robotica hanno un ruolo significativo.

“Il materiale multi-modale è molto eccitante,” ha aggiunto Levine, membro del Berkeley Artificial Intelligence Research facility dell’Università che lavora anche con team di Google.

Elaborando immagini e testo, una rete neurale multi-modale è già in grado di produrre “comandi di robot ad alto livello,” ha detto. Il codice che un robotista scriverebbe normalmente per istruire un robot può essere “completamente automatizzato, in sostanza,” ha detto Levine.

“Ciò che vogliamo è la capacità di comandare rapidamente e facilmente i robot per fare cose,” ha detto Levine. “Colmare quel divario è qualcosa in cui i modelli di linguaggio saranno molto bravi.”

Inoltre: DeepMind’s RT-2 rende il controllo del robot una questione di chat IA

Levine ha contribuito a supervisionare una prima dimostrazione presso Google che è stata pubblicata di recente, chiamata PaLM-E, che i ricercatori di Google definiscono “Un Modello di Linguaggio Multimodale Incarnato.” Il robot è in grado di seguire una serie di istruzioni come “portami le patatine di riso dal cassetto,” che il modello di linguaggio scompone in istruzioni atomiche, come “vai al cassetto,” “apri il cassetto,” “prendi il sacchetto verde di patatine di riso,” ecc.

Un lavoro successivo, dell’unità DeepMind di Google, chiamato RT-2, si basa su PaLM-E aggiungendo la capacità di generare coordinate spaziali per il robot. Levine definisce quel lavoro “un progresso significativo.”

Come per il concetto di stereognosia, Levine sostiene che l’aumento delle modalità può portare a un modello arricchito del mondo e quindi ad alcune capacità di ragionamento di base.

Inoltre: DeepMind’s RT-2 rende il controllo del robot una questione di chat IA

Se grandi modelli di linguaggio e modelli di diffusione possono integrare il processo di “prendere immagini precedenti e prevedere descrizioni [di testo], e prendere descrizioni precedenti e prevedere immagini,” ha detto Levine, “ora potrebbero iniziare, in un certo senso, a scavare più a fondo per quanto riguarda come comprendono il mondo.”

Un esempio primitivo di conoscenza del mondo è un barman robot su cui Levine ha lavorato, che controlla i documenti d’identità delle persone. “In realtà puoi dire al modello di linguaggio, scrivimi un po’ di codice per un barman robot, e questo genera un po’ di logica per farlo, e se qualcuno ordina un bicchiere d’acqua, che non è una bevanda alcolica,” e quindi non richiede un controllo d’identità.

Abbiamo bisogno di molta più memoria

La combinazione di robotica e multi-modalità ha implicazioni più profonde perché espande notevolmente l’appetito per i dati. L’intelligenza artificiale generativa di oggi, come ChatGPT, non ha una memoria esplicita. Funziona solo sull’ultimo gruppo di cose che hai digitato al prompt e dopo un po’ si dimentica delle cose di molto tempo fa.

Utilizzando una modalità mista che include molti più campioni di dati, l’intelligenza artificiale generativa sarà costretta a sviluppare una sorta di memoria reale dei dati. “Quando iniziamo a passare a modelli multi-modalità, diventa molto più esigente in termini di contesto”, ha detto Levine, “perché il prototipo attuale di quel modello prende in input un’immagine, ma forse vuoi dargli mille immagini.

“Forse vuoi fargli vedere un tour della tua casa in modo che sappia dove si trova tutto nella tua casa, così quando gli chiedi di portarti le chiavi dell’auto, può esaminare la sua memoria e capire dove si trovano le chiavi dell’auto – questo richiede un contesto molto più lungo.”

Inoltre:Microsoft, TikTok danno all’IA generativa una sorta di memoria

I dati video possono essere altrettanto, se non più, critici per permettere a un robot di costruire un ritratto del mondo. Quei video, combinati con testo, nuvole di punti e altre modalità, diventano un simulatore con cui un robot può costruire un modello del mondo, ha detto Levine. “Se questi modelli forniscono essenzialmente un modo per imparare simulatori di alta fedeltà, potrebbe avere un impatto molto significativo in futuro.”

Ampliare a migliaia di immagini e possibilmente ore di video, forse gigabyte di dati point-cloud 3D, per addestrare programmi multi-modalità significa che ChatGPT e gli altri dovranno espandere drasticamente il loro accesso ai dati tramite una cosiddetta banca di memoria.

Sono in corso molti sforzi per “potenziare” i modelli di linguaggio con ciò che viene chiamato recupero da un database. Questo può essere visto nel programma CM3Leon di Meta, che consente al software di attingere a un database e trovare immagini pertinenti.

Sforzi come la tecnologia Hyena presso l’Università di Stanford e l’istituto MILA del Canada cercano di espandere drasticamente ciò che può essere inserito nel prompt di un programma in modo che qualsiasi quantità di dati possa essere inserita, di qualsiasi modalità.

Inoltre:Questa nuova tecnologia potrebbe superare GPT-4 e tutto ciò che gli assomiglia

Ciò significa che insieme alla multi-modalità, i successori di ChatGPT saranno in grado di gestire un contesto molto più ampio – libri interi, serie di articoli, film e registrazioni di strutture fisiche in tre dimensioni. Significa anche che il contesto per qualsiasi attività può diventare molto più personalizzato in base alla conoscenza acquisita da un individuo o da un gruppo. Mostaque ha detto che tali modelli porteranno non solo la conoscenza generalizzata di GPT-4, ma anche conoscenze specifiche, così come la conoscenza del tuo team, della tua azienda e oltre.

“Penso che questo sia il grande sblocco, quando passerà all’ambito aziendale l’anno prossimo”, ha detto Mostaque, riferendosi all’imminente adozione popolare dell’IA generativa in contesti aziendali.

Il “Sistema di memoria controllato da sé” di ByteDance, proprietario di TikTok, può attingere a una banca dati di centinaia di dialoghi e migliaia di personaggi, per dare a qualsiasi modello di linguaggio capacità superiori a quelle di ChatGPT nel rispondere alle domande sugli eventi passati. È mostrato nel documento del 2023, “Unleashing Infinite-Length Input Capacity for Large-scale Language Models with Self-Controlled Memory System,” di Xinnian Liang e colleghi presso il ByteDance AI Lab.

Apprendimento continuo raggiungibile

Con l’espansione della multi-modalità al video, all’audio e alle nuvole di punti e a tutto il resto, Keller, CEO dell’azienda di chip AI Tenstorrent, ritiene che modelli generativi più avanzati, specialmente quelli provenienti dalla comunità del software open-source, porteranno a un cambiamento profondo nella distinzione del campo tra addestramento e inferenza.

L’addestramento avviene quando una rete neurale viene sviluppata per la prima volta. È un processo scientifico estremamente costoso, con centinaia o addirittura migliaia di GPU utilizzate. L’inferenza avviene quando la rete finita viene utilizzata per fare previsioni per gli utenti finali, un processo molto meno impegnativo che viene ampiamente implementato come servizio cloud.

Ma “i modelli generativi utilizzano effettivamente molte caratteristiche dell’addestramento nell’inferenza”, ha detto Keller. Un programma come Stable Diffusion di Stability.ai, per la generazione di immagini, aggiorna la sua rete neurale durante l’inferenza, ha detto. “È multipasso: ha anche un passaggio inverso” oltre al tipico processo in avanti delle previsioni, in modo che “sembri che sia in modalità di addestramento”.

Per questo motivo, “Penso che il motore di intelligenza artificiale del futuro… avrà un insieme abbastanza diversificato di capacità che non sembrerà un confronto tra inferenza e addestramento”, ma più come una fusione dei due.

Se Keller ha ragione, i modelli generativi del futuro potrebbero essere l’inizio di un obiettivo a lungo desiderato di apprendimento continuo per l’apprendimento automatico, chiamato anche apprendimento online, in cui una rete neurale generativa non è fissata una volta addestrata, ma continua a evolversi mentre le persone la utilizzano di più.

“Penso che sarà così”, ha concordato Mostaque di Stability.ai. “L’apprendimento continuo sarà fondamentale, perché il modo in cui lo facciamo ora, insegnando [al modello] la stessa cosa più e più volte, non è appropriato.”

Già adesso, ha detto Mostaque, cose come il “Dream Booth” di Stability.ai, che consente di creare una versione personalizzata di un’immagine, stanno andando oltre l’idea rigida di riaddestrare un modello di linguaggio-immagine verso qualcosa di più fluido. Ha detto che diventano avatar personali – e nei prossimi mesi – una sorta di hyper-Dream Booth che consente la personalizzazione di tutte le tue immagini in tempo reale.

“Ecco perché l’apprendimento continuo sarà così importante: per permettere quel processo continuo in modo che si evolva.”