Meno è molto di più quando si tratta di intelligenza artificiale, afferma DeepMind di Google.

DeepMind di Google afferma che meno è molto di più quando si tratta di intelligenza artificiale.

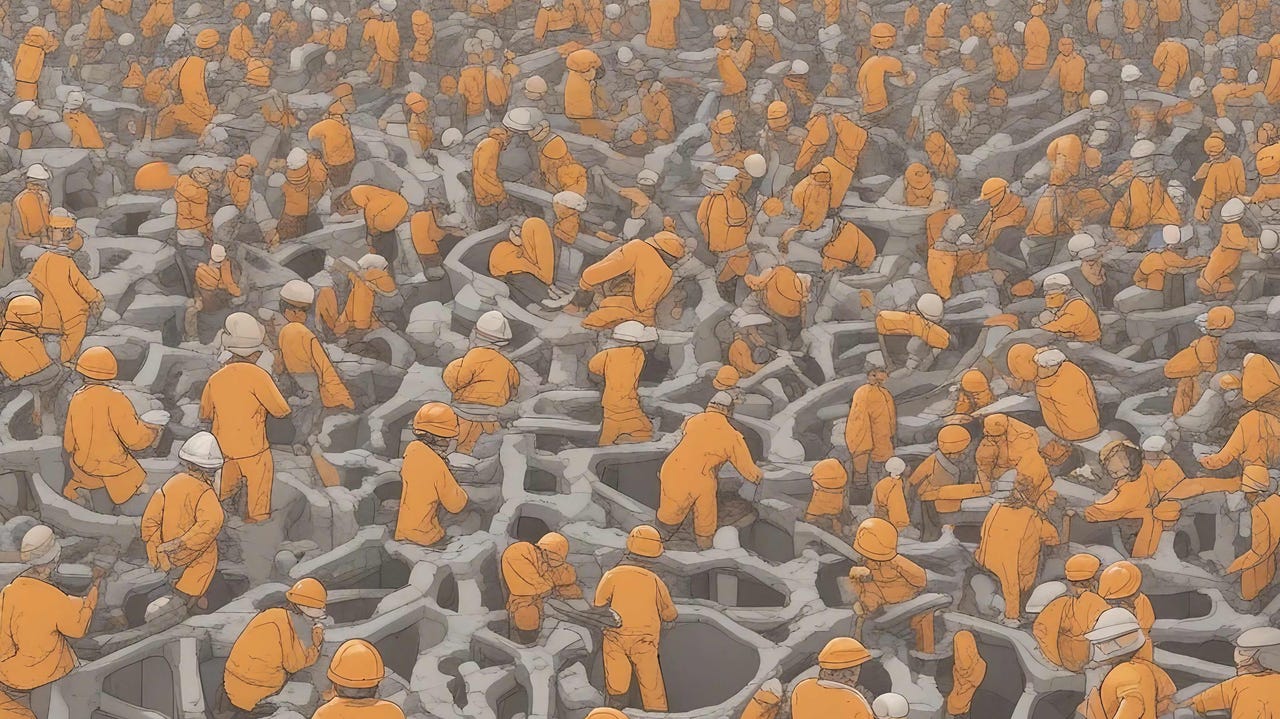

Gli scienziati stanno scoprendo che si può ottenere di più rimuovendo tre quarti di una rete neurale.

Una delle principali ricerche nel campo dell’intelligenza artificiale (AI) è il giusto equilibrio tra la dimensione di un programma e la quantità di dati che utilizza. Dopotutto, costa denaro reale, decine di milioni di dollari, acquistare chip GPU Nvidia per eseguire l’AI e raccogliere miliardi di byte di dati per addestrare le reti neurali – e quanto ne hai bisogno è una domanda con implicazioni molto pratiche.

L’unità DeepMind di Google ha codificato lo scorso anno il giusto equilibrio tra potenza di calcolo e dati di addestramento come una sorta di legge dell’AI. Quella regola empirica, che è stata chiamata “La legge del cincillà”, dice che puoi ridurre la dimensione di un programma a solo un quarto della sua dimensione iniziale se aumenti anche la quantità di dati su cui viene addestrato di quattro volte la dimensione iniziale.

Inoltre: La generative AI può risolvere il più grande problema insoluto delle scienze informatiche?

Il punto del cincillà, ed è un punto importante, è che i programmi possono raggiungere un risultato ottimale in termini di precisione pur essendo meno giganteschi. Costruisci programmi più piccoli, ma addestrali per più tempo sui dati, dice il cincillà. Insomma, meno è più nell’AI di deep learning, per ragioni ancora non del tutto comprese.

- Acquista questa e-bike ora a meno di $900

- Google e HP collaborano su Chromebook ‘Made in India

- Coinbase ottiene la licenza di Istituzione di Pagamento Principale ...

In un articolo pubblicato questo mese, DeepMind e i suoi collaboratori sviluppano ulteriormente questa intuizione suggerendo che è possibile fare ancora meglio rimuovendo intere parti della rete neurale, spingendo le prestazioni oltre quando una rete neurale raggiunge un limite.

Inoltre: La generative AI supererà di gran lunga ciò che ChatGPT può fare. Ecco perché

Secondo l’autore principale Elias Frantar dell’Istituto di Scienza e Tecnologia dell’Austria e i collaboratori di DeepMind, è possibile ottenere gli stessi risultati in termini di precisione da una rete neurale che è la metà di un’altra se si utilizza una tecnica chiamata “sparisità”.

La sparisità, un elemento oscuro delle reti neurali studiato da anni, è una tecnica che si ispira alla struttura effettiva dei neuroni umani. La sparisità si riferisce all’interruzione di alcune delle connessioni tra i neuroni. Nel cervello umano, queste connessioni sono note come sinapsi.

La stragrande maggioranza delle sinapsi umane non si connette. Come osservato dallo scienziato Torsten Hoefler e dal suo team all’ETH Zurigo nel 2021, “I cervelli biologici, in particolare il cervello umano, sono strutture gerarchiche, sparse e ricorrenti”, aggiungendo che “più neuroni ha un cervello, più sparso diventa”.

La teoria è che se potessi approssimare quel fenomeno naturale del numero molto piccolo di connessioni, potresti fare molto di più con qualsiasi rete neurale con molto meno sforzo, tempo, denaro ed energia.

Inoltre: Microsoft, TikTok danno alla generative AI una sorta di memoria

In una rete neurale artificiale, come un modello di AI di deep learning, l’equivalente delle connessioni sinaptiche sono “pesi” o “parametri”. Le sinapsi che non hanno connessioni sarebbero pesi che hanno valori zero: non calcolano nulla, quindi non consumano energia di calcolo. Gli scienziati dell’AI si riferiscono alla sparisità, quindi, come azzeramento dei parametri di una rete neurale.

Nel nuovo articolo di DeepMind, pubblicato sul server di pre-stampa arXiv, Frantar e il suo team si chiedono se reti più piccole possano raggiungere il lavoro di reti più grandi, come ha mostrato lo studio precedente, e quanto la sparisità possa aiutare a spingere le prestazioni ancora più avanti rimuovendo alcuni pesi.

I ricercatori scoprono che se azzeri tre quarti dei parametri di una rete neurale – rendendola più sparuta – può fare lo stesso lavoro di una rete neurale più del doppio delle sue dimensioni.

Come affermano: “Il messaggio chiave di questi risultati è che addestrando significativamente più a lungo rispetto al cincillà (ottimizzazione di calcolo densa), sempre più modelli sparuti iniziano a diventare ottimali in termini di perdita per lo stesso numero di parametri non zero”. Il termine “modello di calcolo denso” si riferisce a una rete neurale che non ha sparisità, quindi tutte le sue sinapsi sono operative.

“Questo accade perché i vantaggi dell’ulteriore allenamento dei modelli densi iniziano a rallentare significativamente in un certo punto, permettendo ai modelli sparsi di superarli.” In altre parole, i modelli normali, non sparsi — i modelli densi — iniziano a deteriorarsi dove le versioni sparse prendono il sopravvento.

Inoltre: Vedremo un tipo completamente nuovo di computer, afferma il pioniere dell’IA Geoff Hinton

L’implicazione pratica di questa ricerca è sorprendente. Quando una rete neurale inizia a raggiungere il suo limite in termini di prestazioni, ridurre effettivamente la quantità dei suoi parametri neurali che funzionano — azzerandoli — estenderà ulteriormente le prestazioni della rete neurale mentre si allena per un tempo sempre più lungo.

“I livelli di sparsità ottimali aumentano continuamente con un allenamento più lungo,” scrivono Frantar e il suo team. “La sparsità fornisce quindi un modo per migliorare ulteriormente le prestazioni del modello per un costo finale dei parametri fisso.”

Per un mondo preoccupato per il costo energetico delle reti neurali sempre più esigenti, la buona notizia è che gli scienziati stanno scoprendo che si può fare ancora di più con meno.