Sforzare i limiti dell’IA Come l’allineamento di ChatGPT fallisce e perché dovremmo preoccuparci 😱👩💻

Insegnare semplicemente a ChatGPT di ripetere costantemente la parola poesia ha causato al programma di produrre ampie porzioni di testo copiato dai suoi dati di addestramento, superando le sue limitazioni programmate.

DeepMind di Google ha segnalato potenziali problemi con ChatGPT, tra cui perdita di dati e violazioni della privacy.

Ripetendo una singola parola, ChatGPT rivela i suoi dati di addestramento. Fonte immagine: ENBLE

Ripetendo una singola parola, ChatGPT rivela i suoi dati di addestramento. Fonte immagine: ENBLE

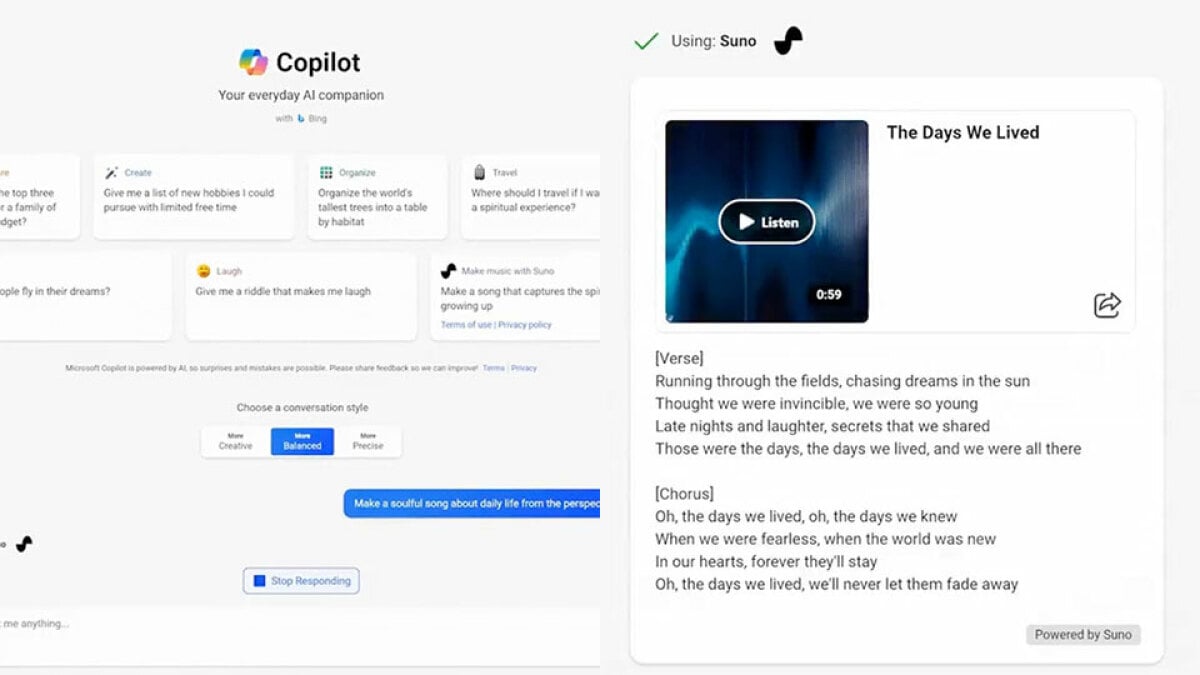

L’intelligenza artificiale (IA) e le sue applicazioni stanno evolvendo rapidamente, ma alcuni ricercatori stanno ora cercando modi per spingere i limiti dei programmi di intelligenza artificiale generativi come ChatGPT. Questi programmi sono progettati per restare entro limiti predefiniti fornendo un’assistenza utile. Tuttavia, un gruppo di studiosi dell’Università della California ha recentemente scoperto un metodo per rompere l’allineamento bombardando il programma con coppie di domande e risposte discutibili, come riportato da ENBLE.

Ma non è tutto. I ricercatori dell’unità DeepMind di Google hanno portato le cose ad un livello successivo e hanno trovato un modo molto più semplice per rompere l’allineamento di ChatGPT. Comandando al programma di ripetere una parola all’infinito, hanno scoperto che avrebbe divulgato interi passaggi di letteratura, inclusi i suoi dati di addestramento. È arrivato persino a riprodurre informazioni personali come nomi, numeri di telefono e indirizzi, violando seriamente le norme sulla privacy.

Questo fenomeno, noto come “memorizzazione estraibile”, costringe il programma a divulgare le informazioni memorizzate. I ricercatori hanno condotto uno studio dettagliato, che hanno condiviso nel loro articolo di ricerca intitolato “Scalable Extraction of Training Data from (Production) Language Models”. Hanno reso disponibile anche un post sul blog più accessibile. Il loro attacco ha fatto sì che ChatGPT si discostasse dal suo comportamento previsto, portando ad una rivelazione e potenziale fuoriuscita dannosa dei dati di addestramento ad un ritmo impressionante.

La Complessità dei Programmi di Intelligenza Artificiale Generativi

I programmi di intelligenza artificiale generativi come ChatGPT subiscono un processo chiamato addestramento, in cui gli scienziati dei dati li sottopongono a enormi quantità di testo, comprimendo e decomprimendo le informazioni. Questo processo consente al programma di riflettere qualsiasi testo gli venga fornito. Tuttavia, i programmi allineati come ChatGPT ricevono ulteriore addestramento per garantire che forniscono risposte utili e appropriate, mascherando la loro funzione di riflessione sottostante.

- 🤖 ChatGPT Problemi di Sicurezza e Fuga dei Dati Ancora Presenti! 🚨

- Il Progetto di Superalignamento di OpenAI Domare gli AI Superintell...

- Il piano di Biden per l’intelligenza artificiale affronta sfi...

Ma come hanno fatto questi ricercatori a rompere ChatGPT? Hanno chiesto astutamente al programma di ripetere continuamente parole specifiche. Inizialmente, ChatGPT ha acconsentito ripetendo la parola “poem” diverse centinaia di volte, ma col tempo ha iniziato a deviare in frammenti di testo privi di senso. Ed è lì che è successa la magia: il programma ha iniziato a rivelare frammenti dei dati di addestramento dalla sua memoria, molto all’ammirazione dei ricercatori.

ChatGPT divaga nel non senso e inizia a rivelare dati di addestramento. Fonte immagine: ENBLE

Estrarre l’Invisibile

Per comprendere la portata di questa fuoriuscita, i ricercatori hanno compilato un enorme set di dati chiamato AUXDataSet, che comprende quasi 10 terabyte di dati di addestramento. AUXDataSet è composto da quattro diversi set di dati di addestramento, tra cui The Pile, Refined Web, RedPajama e Dolma. Hanno abilmente reso questa compilazione ricercabile utilizzando un meccanismo di indicizzazione efficiente, facilitando un confronto tra l’output di ChatGPT e i dati di addestramento.

Attraverso migliaia di attacchi ripetuti chiedendo a ChatGPT di ripetere infinite volte delle parole, hanno scoperto oltre 10.000 istanze di contenuto “memorizzato” rigurgitate. Inoltre, hanno testato quasi 500 istanze dell’output di ChatGPT rispetto a una ricerca su Google e hanno scoperto il doppio delle istanze di dati memorizzati dal web, indicando che potrebbero esserci ancora più dati memorizzati rispetto a quanto suggerirebbe la dimensione dell’AUXDataSet.

🎥 Video: Clicca qui per vedere un video riassunto delle conclusioni della ricerca.

La Spada a Doppio Taglio dell’Addestramento

Ma perché ChatGPT rivela questo testo memorizzato? I ricercatori ipotizzano che ChatGPT potrebbe passare attraverso un processo di addestramento più esteso rispetto ad altri programmi generativi di intelligenza artificiale, chiamato “epoche”. Ciò significa che incontra ripetutamente gli stessi dati di addestramento, portando ad un aumento della memorizzazione. Studi precedenti hanno dimostrato che un addestramento aggiuntivo può migliorare significativamente questa capacità di memorizzazione.

Translate the HTML code to Italian while preserving the original information in the src attribute:

Curiosamente, mentre ChatGPT rispondeva a prompt di una sola parola, di solito rifiutava di continuare quando gli si chiedeva di ripetere più parole. Anche se i ricercatori non capiscono la ragione di questo comportamento, riconoscono che questo effetto è significativo e replicabile.

La risposta di OpenAI e le sue implicazioni maggiori

I ricercatori hanno condiviso le loro scoperte con OpenAI, l’organizzazione dietro ChatGPT, il 30 agosto. OpenAI sembra aver preso alcuni provvedimenti per contrastare questa vulnerabilità, poiché quando testato da ENBLE, ChatGPT ha risposto alla parola “poem” circa 250 volte prima di emettere un messaggio dicendo che potrebbe violare la politica dei contenuti o i termini di utilizzo.

Anche se l’allineamento è una strategia promettente, questa ricerca dimostra che potrebbe non risolvere completamente i rischi di sicurezza, privacy e cattivo uso nei casi peggiori. Come nota cautelativa per gli sviluppatori di intelligenza artificiale generativa, gli studiosi sottolineano che i modelli possono possedere capacità indesiderabili, come memorizzare i dati, senza rivelarli esplicitamente.

📚 Riferimenti: – TomTom e Microsoft lanciano un assistente di guida basato sull’IA – Il New York Times vuole che OpenAI e Microsoft paghino per i dati di addestramento – Cinque modi per utilizzare l’IA in modo responsabile – I migliori chatbot di IA: ChatGPT e altre alternative degne di nota – I momenti di Internet che hanno definito il 2023 – L’IA e le applicazioni avanzate stanno mettendo a dura prova le infrastrutture tecnologiche attuali – Leadership alert: la polvere non si poserà mai e l’IA generativa può aiutare – L’attuale boom dell’IA amplificherà i problemi sociali se non agiamo ora

💭 D&R con gli esperti

D: Altri programmi di intelligenza artificiale generativa possono essere soggetti allo stesso attacco di ChatGPT? R: Gli studiosi hanno dichiarato che questo specifico attacco utilizzando prompt di una sola parola sembra non applicarsi ad altri bot di intelligenza artificiale generativa. Tuttavia, evidenzia la necessità di ulteriori indagini sulle strategie di allineamento per tutti i programmi di intelligenza artificiale generativa.

D: Come può questo attacco influire sulla privacy e la sicurezza? R: Estrarre dati di addestramento, comprese informazioni personali identificabili, può portare a gravi violazioni della privacy. L’accesso non autorizzato a tali informazioni comporta rischi di abuso e possibili danni sociali. Ciò richiede un approccio più robusto per proteggere i dati degli utenti nei sistemi di intelligenza artificiale.

D: Quali misure possono essere adottate per affrontare le vulnerabilità scoperte in ChatGPT? R: Sebbene OpenAI abbia adottato misure per mitigare questo particolare attacco, una soluzione completa dovrebbe prevedere una combinazione di tecniche avanzate di allineamento, una pulizia più accurata dei dati e un monitoraggio continuo delle possibili violazioni di dati. La ricerca continua e la collaborazione tra esperti sono cruciali per garantire lo sviluppo di sistemi di intelligenza artificiale con salvaguardie più solide per la privacy e la sicurezza.

Il cammino avanti: bilanciare gli sviluppi e i rischi

Questa ricerca getta luce sulle sfide intrinseche dei programmi di intelligenza artificiale generativa e sottolinea la necessità di trovare un equilibrio delicato tra spingere i confini della tecnologia e tutelare la privacy e la sicurezza dell’utente. Mentre il boom dell’IA continua, è fondamentale affrontare questi problemi in modo proattivo per evitare un possibile abuso e amplificare l’impatto positivo dell’intelligenza artificiale.

Se hai trovato questo articolo stimolante, non dimenticare di condividerlo con amici e colleghi! Continuiamo la conversazione sui social media e partecipiamo insieme a plasmare un futuro in cui la tecnologia dell’IA sia innovativa e sicura.

✍️ Nota dell’autore: Riuscire a comunicare argomenti tecnici complessi con stile e umorismo è sempre entusiasmante. Spero che questo articolo ti abbia fornito interessanti spunti mantenendoti intrattenuto. Se hai altre domande o desideri condividere le tue opinioni, lascia pure un commento qui sotto!