Il Lato Oscuro della Tecnologia AI Generativa Prevenzione, Immagini False e Disinformazione

Rimani al top del sempre mutante panorama dell'AI con il nostro riepilogo settimanale delle ultime novità.

“`html

Preparati a più immagini AI false mentre le battaglie tra OpenAI-Musk e OpenAI-NYT persistono.

Introduzione

La tecnologia Generative AI ha rivoluzionato varie industrie permettendo la creazione di testi, immagini, video e persino codice di programmazione con capacità di linguaggio naturale. Questo significa che chiunque può interagire con i chatbot AI senza bisogno di competenze di programmazione o ingegneristiche. Tuttavia, c’è un lato oscuro in questa tecnologia che include pregiudizi, allucinazioni e la creazione di immagini e video falsi. In questo articolo, esploreremo alcuni esempi recenti delle conseguenze negative della Generative AI e discuteremo le preoccupazioni che sollevano.

L’Offesa delle Immagini Offensive

Appena una settimana dopo che il generatore di testo-immagine Gemini di Google ha ricevuto critiche per la consegna di immagini offensive e di parte, il generatore AI di progettazione di Copilot di Microsoft ha affrontato critiche simili. Un ingegnere di Microsoft, Shane Jones, ha espresso preoccupazione per le immagini disturbanti e violente create dallo strumento AI, tra cui demoni, mostri, immagini sessualizzate di donne e consumo di alcolici e droghe da parte di minorenni. Queste immagini violavano chiaramente i principi di AI responsabile di Microsoft. Nonostante gli sforzi di Jones per affrontare i problemi, Microsoft ha ignorato le sue scoperte. Questo solleva dubbi sulle pratiche etiche seguite dalle aziende AI e sul danno potenziale causato dall’abuso della tecnologia Generative AI.

Immagini False e Disinformazione

In un’altra situazione, i sostenitori dell’ex Presidente Donald Trump hanno creato foto false raffiguranti il candidato presidenziale circondato da elettori neri falsi. L’intenzione di queste immagini fabbricate era quella di ingannare gli afroamericani affinché votassero repubblicano. Questa manipolazione di immagini mette in evidenza il problema più ampio della disinformazione e il potenziale delle immagini generate da AI nel diffondere le menzogne durante le elezioni. Secondo un rapporto del Center for Countering Digital Hate, gli strumenti di immagine AI contribuiscono alla disinformazione elettorale nel 41% dei casi, incluse la creazione di immagini a supporto di false affermazioni su candidati o frodi elettorali. Questo solleva preoccupazioni sulla affidabilità dei contenuti creati utilizzando la tecnologia Generative AI.

Biden Chiede un Divieto delle Impersonazioni di Voce AI

Nel suo discorso sullo stato dell’Unione, il Presidente Biden ha chiesto un divieto delle impersonazioni di voce AI e una legislazione per sfruttare la promessa dell’AI proteggendo la società dai suoi potenziali pericoli. Truffatori avevano precedentemente utilizzato robocall generati da AI con la voce di Biden per ingannare gli elettori democratici durante le primarie presidenziali del New Hampshire. Sebbene ci siano preoccupazioni sui pericoli delle impersonazioni vocali, ci sono anche casi d’uso potenziali che dimostrano gli aspetti positivi delle voci generate da AI, come l’app Calm che presenta una narrazione generata da AI dell’attore Jimmy Stewart per una storia della buonanotte. Trovare il giusto equilibrio tra la regolamentazione delle applicazioni dannose dell’AI e il consenso di quelle utili è cruciale.

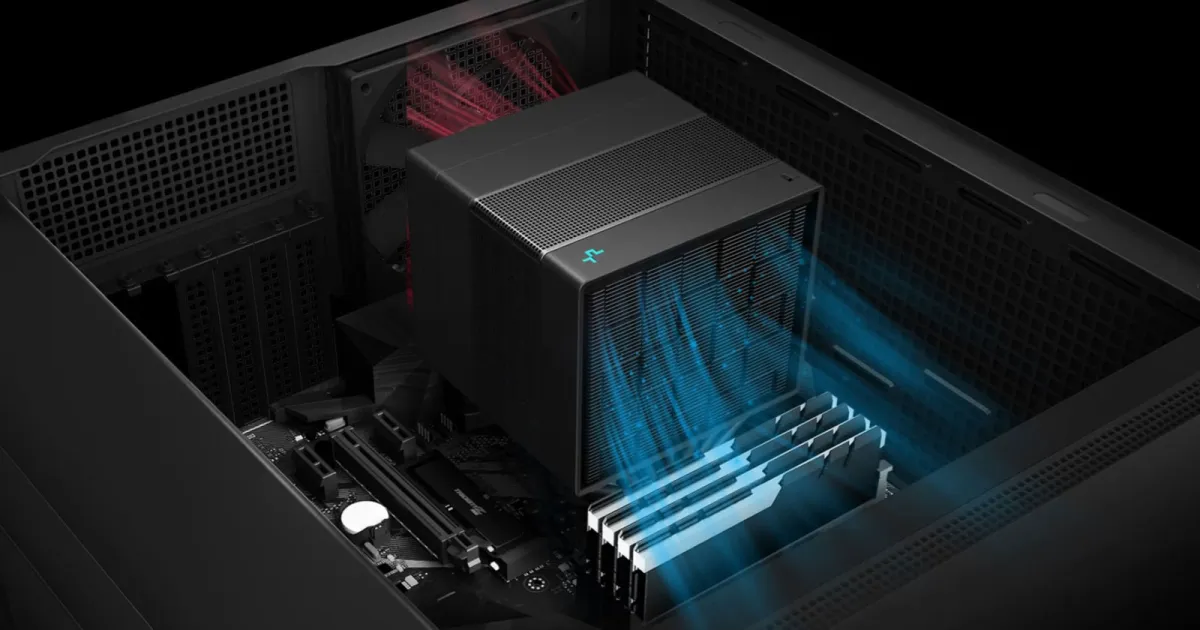

- Potenzia il tuo spazio di archiviazione dati con il Polar Wolf Alum...

- Microsoft si prepara a stupire con il nuovo Surface Pro 10 e Surfac...

- Svelare il Thunderbolt Guida Completa all’Interfaccia Hardwar...

Il Chatbot “Umano” di Anthropic e la Concorrenza

Anthropic, un’azienda AI con sede a San Francisco, ha rilasciato Claude 3, un rivale di ChatGPT di OpenAI e di Gemini di Google. Anthropic afferma che i suoi modelli AI ora dimostrano “comprensione umana” e hanno una maggiore accuratezza e comprensione contestuale. Anche se questi chatbot non sono una vera intelligenza artificiale generale e mancano della completa comprensione come gli esseri umani, gli aggiornamenti a Claude dimostrano il rapido ritmo di innovazione nel campo della Generative AI. OpenAI ha recentemente annunciato la sua collaborazione con varie aziende tecnologiche per costruire, implementare e utilizzare l’AI responsabilmente, nonostante sia stata intentata una causa legale da Elon Musk, uno degli investitori iniziali di OpenAI. La concorrenza e la controversia attorno alla AI generativa mostrano che c’è ancora molto da esplorare e risolvere in questo campo in rapida evoluzione.

La Necessità di Trasparenza nella Valutazione dell’AI

Un gruppo di oltre 100 ricercatori AI ha firmato una lettera aperta sottolineando l’importanza dell’evaluazione indipendente dei sistemi gen AI. Essi sostengono che le aziende AI dovrebbero permettere agli investigatori di accedere ai loro sistemi per controlli di sicurezza prima di rilasciarli al pubblico. Attualmente, le restrizioni sulla ricerca indipendente creano un effetto scoraggiante, poiché gli ispettori temono di essere banditi o di affrontare azioni legali per testare modelli AI senza il permesso delle aziende. I ricercatori enfatizzano la necessità di trasparenza, responsabilità e il rischio di ostacolare la ricerca, citando esempi in cui le aziende AI hanno escluso gli ispettori esterni dall’accesso ai loro sistemi. Trovare un equilibrio tra sicurezza e favorire la ricerca indipendente nel campo della Generative AI rimane una sfida.

La Battaglia Legale tra Microsoft e OpenAI per Violazione del Copyright

Le cause di violazione del copyright hanno colpito lo spazio gen AI, con creatori di contenuti che accusano aziende come OpenAI e Microsoft di utilizzare le loro opere senza permesso o compensazione. Il New York Times ha intentato una causa legale contro OpenAI e Microsoft, sostenendo che queste aziende hanno usato illegalmente milioni delle sue storie per addestrare i loro modelli linguistici, facendo concorrenza alle aziende mediatiche come fonte affidabile di informazioni. Sia Microsoft che OpenAI hanno lanciato argomentazioni contro la causa legale, affermando che la dottrina dell’uso lecito protegge il loro utilizzo di materiale protetto da copyright. Questa battaglia legale in corso mette in evidenza l’importanza nel determinare i confini dell’uso dei dati nell’addestramento dei sistemi generativi AI.

“““html

Conclusione

La tecnologia AI generativa ha un enorme potenziale per trasformare vari campi, ma comporta anche rischi e preoccupazioni etiche. Eventi recenti hanno evidenziato preconcetti, la creazione di immagini/video falsi, la diffusione di disinformazione e battaglie legali per i diritti di proprietà intellettuale. Trovare un equilibrio tra sfruttare il potere dell’AI generativa e mitigare i suoi potenziali rischi è cruciale. Garantire trasparenza, responsabilità e uso responsabile dell’AI sarà vitale mentre facciamo avanzamenti ulteriori in questo campo in rapida evoluzione.

Sezione Q&A

Q: Quali possono essere le conseguenze potenziali dei preconcetti nell’AI generativa? I preconcetti nell’AI generativa possono perpetuare stereotipi ingiusti, rafforzare la discriminazione e approfondire le divisioni nella società. Quando i sistemi AI vengono addestrati su dati prevenuti o non rappresentativi, possono generare contenuti che riflettono quei pregiudizi. Inoltre, i pregiudizi nei sistemi AI possono portare a processi decisionali discriminatori in vari ambiti come le assunzioni o le approvazioni di prestiti. Affrontare e mitigare i pregiudizi nell’AI generativa è essenziale per creare una tecnologia equa ed equa.

Q: In che modo la tecnologia AI generativa può essere utilizzata in modo positivo? La tecnologia AI generativa ha applicazioni positive in aree come la creazione di contenuti, la narrazione, gli assistenti virtuali e la personalizzazione. Ad esempio, i contenuti generati dall’AI possono aiutare autori, registi e artisti a generare nuove idee e ispirazioni. Gli assistenti virtuali basati sull’AI generativa possono fornire esperienze personalizzate, rendendo le interazioni più efficienti e adattate alle esigenze individuali. È importante esplorare il potenziale positivo dell’AI generativa pur essendo consapevoli delle considerazioni etiche e dell’uso responsabile.

Q: Quali misure possono essere adottate per affrontare la diffusione di disinformazione attraverso i contenuti generati dall’AI generativa? Affrontare la disinformazione richiede un approccio poliedrico che coinvolge misure tecnologiche, normative ed educative. Gli sviluppi tecnologici possono concentrarsi sulla creazione di sistemi AI in grado di rilevare e segnalare contenuti potenzialmente falsi o fuorvianti generati dall’AI generativa. I quadri normativi possono essere implementati per garantire trasparenza, responsabilità e uso responsabile della tecnologia AI generativa. Educare gli utenti sui rischi e sulle limitazioni dei contenuti generati dall’AI generativa può anche permettere loro di valutare e verificare criticamente le informazioni.

Riferimenti

- L’AI Chatbot va fuori controllo, generando contenuti offensivi

- Gemini Flubs di Google e Musk fa causa a OpenAI

- NSA Acquista i Record di Navigazione su Internet degli Americani

- Principi e Responsabilità dell’AI

- Fabbriche di Immagini False: Contrastare la Disinformazione con l’AI

“`